Données externes et open data : effet de mode ou réelle valeur ajoutée ?

Cet article (5 minutes de lecture) présente les principaux enjeux liés aux données externes et à l’Open Data : que sont ces données ? Pourquoi s’y intéresser ? Comment y accéder, et à quel coût ?

LES DONNÉES EXTERNES, QUÉSACO ?

« Notre volonté, c’est de supprimer les silos au sein de l’entreprise, exploiter et tirer de la valeur des données d’où qu’elles viennent : opérations, marketing, RH, … »

De manière très caricaturale, voici sans doute l’ambition reine dès lors qu’il s’agit de justifier et expliquer les enjeux de la Data Science, et plus généralement du Big Data, au sein d’une entreprise. Utiliser des données externes, c’est simplement pousser encore plus loin cette ambition.

Exploiter les données internes à l’entreprise, c’est bien; y adjoindre des données extérieures à l’entreprise, c’est-à-dire qui n’ont pas été produites par elle, ça peut être mieux !

L’intérêt de considérer et d’intégrer – éventuellement – ces données est d’explorer facilement et rapidement des périmètres parfois moins bien connus par le métier, mais qui pourtant peuvent être vecteurs de valeur.

D’une part, lesdites données peuvent améliorer la performance de modèles mis en place par l’entreprise; le ROI est donc “immédiat”. Leur introduction dans les modèles peut prendre deux formes :

-

Soit elles sont considérées comme des variables explicatives à part entière. Par exemple, pour un modèle de scoring d’appétence client dans l’univers de la santé, il avait été décidé d’inclure les coûts d’honoraires médicaux moyens de la zone géographique du client.

-

Soit elles sont mixées avec des variables explicatives déjà existantes. Par exemple, pour une modélisation de comportements clients, le revenu d’un individu avait été contextualisé par son lieu d’habitation en faisant le ratio de son revenu et du revenu médian de sa zone géographique.

D’autre part et dans une démarche un peu plus long terme, elles peuvent nourrir des réflexions sur de nouveaux cas d’usage. Avoir à l’esprit que ces données existent et sont accessibles peut constituer un véritable accélérateur d’innovations.

Ce sont deux types de configurations qui se sont présentées au cours de missions chez nos clients.

QUI SONT-ELLES ET OÙ LES TROUVE-T-ON ?

Aujourd’hui, les méthodes et algorithmes utilisés pour adresser des problématiques data sont identifiés et maîtrisés. Souvent disponibles « sur étagère » et packagés dans des librairies simplement utilisables, ils rendent le travail des data scientists plus simple. Traditionnellement, ces algorithmes estiment des modèles sur des données dont le scope est interne à l’entreprise. De la même façon, existe-t-il des données externes à l’entreprise disponibles « sur étagère », prêtes à être consommées par des procédures algorithmiques ?

Depuis plusieurs années, l’Open Data (public ou privé) et l’APIfication des services occupent une place de choix sur la toile. Et c’est principalement grâce à ces outils qu’il devient facile d’accéder à des données externes.

En quelques mots, l’Open Data public fait référence – en France – à l’action du gouvernement de rendre ouvertes depuis 2011 un vaste ensemble de données libres d’utilisation. L’INSEE met par exemple à disposition des données macroéconomiques (principaux indicateurs économiques nationaux comme le chômage, la démographie, …) et microéconomiques (indicateurs de richesse à la maille communale comme le revenu) ; le gouvernement met à disposition des données dans des domaines aussi variés que l’agriculture, la culture, l’éducation, la santé, les territoires, et bien d’autres (voir le site officiel). A titre d’exemple, ce sont quelques 220 jeux de données qui sont disponibles rien que pour la ville de Paris (voir les données disponibles). Le vivier est donc vaste.

L’Open Data est aussi une pratique du secteur privé (ou semi-privé), puisqu’un grand nombre d’acteurs rendent leurs données accessibles (avec parfois certaines limitations); les réseaux sociaux (Twitter, LinkedIn, …), certaines banques comme BPCE, la Banque de France ; ou encore des institutions comme Eurostat, le FMI, l’OCDE, …

Enfin, si l’APIfication mériterait un article dédié, elle peut se résumer en une standardisation de l’accès à la donnée, quel que soit le service considéré. Cela simplifie grandement le travail du curieux, qui se résume in fine à des requêtes génériques. Google a par exemple mis en place une API permettant à un utilisateur d’interagir simplement avec Google Maps… Sans pour autant avoir une quelconque connaissance de Google Maps, et encore moins de sa structure de données. Google est loin d’être un cas isolé, puisque nombre d’autres corporations ont fait de même.

ET EN PRATIQUE ?

Plusieurs alternatives s’offrent aux curieux.

Soit les données sont directement accessibles sous forme de fichiers (c’est le cas de l’INSEE par exemple). Auquel cas, la récupération de données se matérialise par un simple téléchargement.

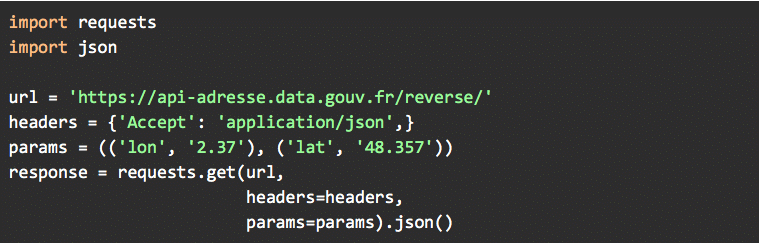

Soit les données sont requêtables via une API ; auquel cas, des compétences (légères) en programmation sont requises pour communiquer avec l’API, et tout devrait se passer simplement, modulo quelques requêtes GET (c’est le cas de data.gouv par exemple), puisque tout est fait pour que la donnée reçue ne soit pas polluée, et intelligible rapidement. A titre d’exemple, la simple requête ci-dessous permet d’accéder à l’adresse d’un lieu à partir de ces coordonnées géodésiques. L’opération inverse est réalisable aussi simplement, et permet donc d’être intégrée dans de nombreux cas d’usages.

Soit les données sont requêtables mais aucune API n’est disponible ; auquel cas, il est nécessaire de scrapper (i.e. extraire de la donnée directement depuis un site Web) directement la source de données, dans la limite de sa tolérance au scrapping. Un coût de nettoyage est souvent à prévoir en cas de scrapping, puisque la donnée récupérée est dans un format brut (code HTML, …). Des dizaines de librairies existent dans des dizaines de langages. A titre d’exemple, les librairies BeautifulSoup, lxml ou encore requests sont assez populaires en Python, et faciles de prise en main.

Enfin, aborder les aspects pratiques commande également de discuter coûts. Le coût de cette donnée ouverte est globalement proportionnel à la précision qui est attendue d’elle : les données publiques, indicateurs nationaux agrégés ou à l’échelle de la commune, sont généralement gratuites. Certains acteurs privés mettent également à disposition des données gratuitement. Au contraire, les données “ultra précises” (comprendre non agrégées, ou très localisées par exemple) sont rarement gratuites ; à titre d’illustration, c’est le cas des données de météo locales. Dans ce cas de figure, l’utilisateur achète de la donnée comme n’importe quel autre produit, via des data marketplace par exemple (ici un exemple de data marketplace). Cette donnée, bien que payante, reste ouverte, puisqu’un accès direct à elle est rendu possible.

CONCLUSION

Les bénéfices de considérer les données ouvertes peuvent être multiples. Ces données sont susceptibles d’améliorer la performance des modèles ; et elles peuvent apporter un angle original dans l’optique de nouveaux cas d’usages. L’investissement sur ces données peut donc valoir le coup.

Cependant, attention à ne surtout pas les substituer à une exploitation approfondie des données disponibles en interne ; ce sont ces données qui doivent toujours prévaloir. Elles sont les plus robustes, puisque leur intégrité et leur disponibilité sont maitrisées ; alors que l’intégrité et la disponibilité des données externes ne dépendent que du tier qui les détient.