IA pour l'assurance : risques et opportunités

L’introduction de l’Intelligence Artificielle représente plusieurs opportunités pour les métiers de l’assurance, à condition toutefois de préserver la confiance.

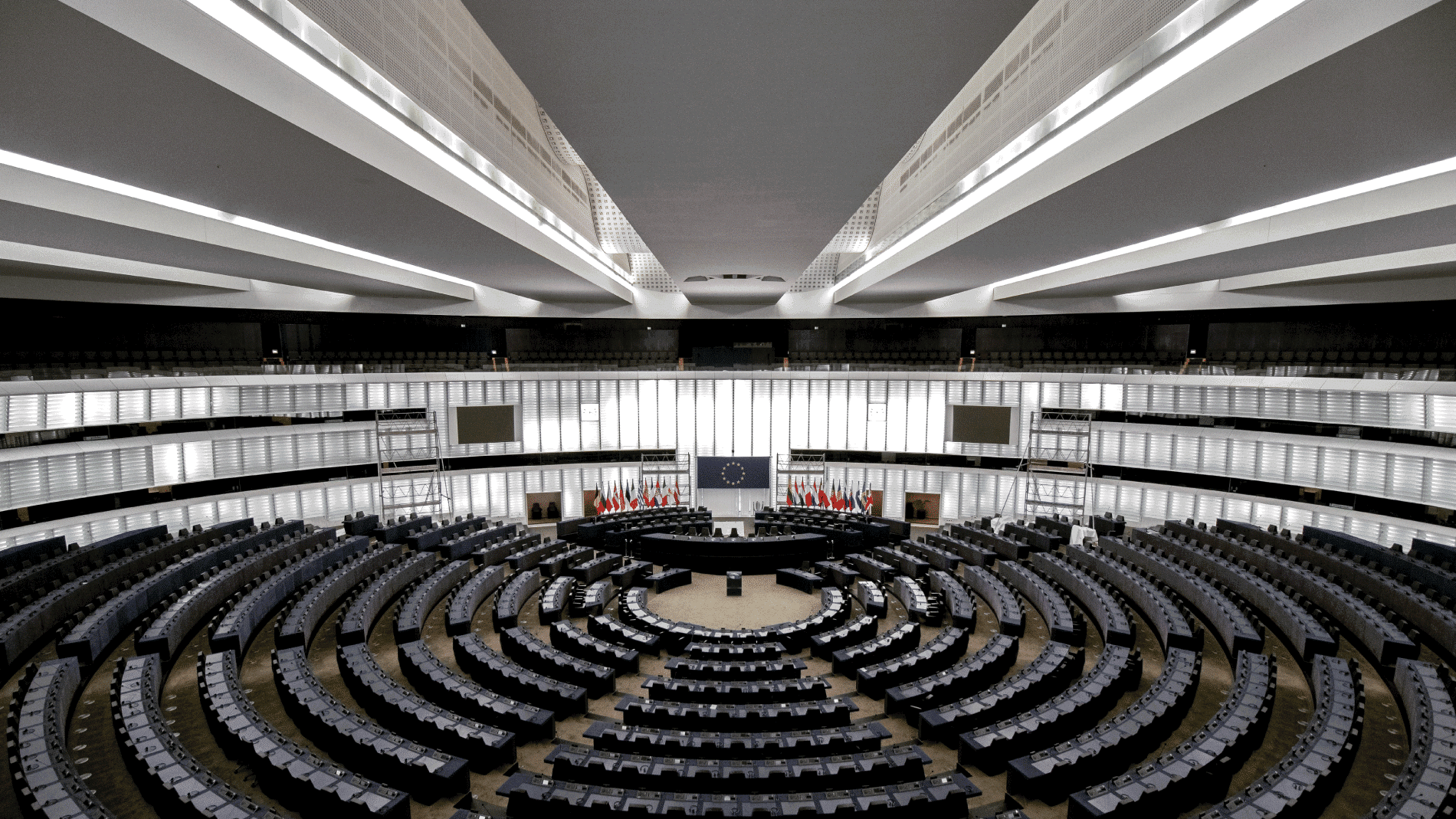

Quantmetry travaille depuis plusieurs années sur l’IA de confiance, et revient dans cet article sur les exigences à intégrer et sur l’enjeu du contrôle dans le secteur de l’assurance en s’appuyant notamment sur les travaux menés par l’ACPR et le parlement européen.

L’IA comme levier de transformation de l’assurance

L’assurance est un métier historique de la donnée. Il n’est donc pas surprenant de constater que l’IA est aujourd’hui un levier de transformation majeur (et efficace) qui touche à de multiples aspects du métier :

- Amélioration des processus (contractualisation, gestion des sinistres)

- Évaluation des risques

- Amélioration de la relation assurés

- Fraudes et lutte anti-blanchiment (LCB-FT)

- Personnalisation et développement de nouveaux services

Les levées de fonds records des assurtech en 2019 témoignent de cette dynamique.

https://www.argusdelassurance.com/acteurs/la-planete-assurtech-en-pleine-revolution.160474

Le besoin de confiance

Si l’assurance est un métier de la donnée, c’est aussi un métier de confiance qui implique des exigences fortes.

Il est donc essentiel de pouvoir répondre à des questions légitimes quant à l’introduction de l’IA : pourquoi un algorithme donne tel résultat ? Quel niveau de confiance peut-on avoir dans ce résultat ? Comment s’assurer que le résultat n’est pas discriminant ? quels usages de mes données ?…

Le législateur qui veille à l’intérêt des citoyens et les professionnels du secteur ont bien compris la nécessité d’exprimer et de formaliser ces exigences indispensables à la confiance.

La Commission Européenne a lancé des travaux pour compléter la GDPR en intégrant les questions posées par l’utilisation de l’IA (1). Ces travaux devraient aboutir en 2021 à une réglementation générale applicable à tous les secteurs d’activité.

De son côté, l’ACPR (Autorité de Contrôle Prudentiel et de Résolution) a publié un document de travail (2) et lancé une consultation en juin dernier sur ce sujet. Les travaux de l’ACPR s’appuient sur ceux de la Commission Européenne et visent à adresser les spécificités du secteur finance, notamment en termes de risques et de gouvernance.

La Commission Européenne a structuré les risques (et les exigences) autour des 7 thématiques suivantes :

- Facteur humain et contrôle humain

- Robustesse technique et sécurité

- Respect de la vie privée et gouvernance des données

- Transparence

- Diversité, non-discrimination et équité

- Bien-être sociétal et environnemental

- Responsabilisation

Nous revenons sur ces 7 dimensions dans un article de notre blog : https://www.quantmetry.com/blog/ia-ethique-commission-europeenne/

Les techniques et les pratiques qui permettent de répondre à ces exigences se développent et gagnent en maturité mais restent parfois encore insuffisantes pour répondre parfaitement aux enjeux.

Elles portent notamment sur :

- l’intelligibilité (comprendre ou expliquer les résultats d’une IA)

- la confidentialité (privacy) : anonymisation, pseudonymisation,..

- le contrôle des biais et des données d’entraînement ; techniques de débiaisage

- le suivi des dérives et la gestion du cycle de vie des modèles et des données

- les pratiques d’intégration dans les processus métiers et l’audit

Le besoin de contrôle

Ce besoin de confiance entraîne une nécessité de contrôle et de validation des algorithmes concernés.

La mise en place d’un tel contrôle soulève notamment 3 challenges majeurs :

- disposer d’exigences claires et comprises,

- un dispositif de contrôle continu,

- des personnes pour contrôler.

Exprimer des exigences claires

Une première difficulté de l’évaluation est qu’elle implique une expression claire et précise des exigences. Les attentes telles qu’exprimées dans le paragraphe précédent sont beaucoup trop floues pour permettre d’évaluer ou de valider un algorithme. Par exemple, l’explicabilité est une notion bien trop vague pour constituer une exigence en tant que telle. Il s’agit en réalité davantage de savoir jusqu’à quel point un algorithme doit être explicable plutôt que de savoir s’il l’est ou pas. Le document de travail de l’ACPR propose ainsi de préciser 4 niveaux d’explicabilité et d’associer les cas d’usage métier au niveau d’explicabilité requis, en fonction du risque.

Il s’agit ensuite de prendre en compte ces attentes au plus tôt dans le cycle projet, dès la conception, en impliquant les parties prenantes qui portent ces exigences au sein de l’organisation, et en particulier les métiers, les spécialistes de la data et le contrôle interne.

Afin de permettre un audit ultérieur, il est donc essentiel de documenter, lors de la phase de conception, les réponses apportées à chacune des exigences.

Mettre en place une validation continue

Cependant, s’agissant de Machine Learning, on ne peut se limiter à valider la conception des algorithmes, puisqu’ils peuvent “ré-apprendre” sur de nouvelles données, et voir ainsi leurs caractéristiques évoluer avec le temps. Il est donc nécessaire de définir également les moyens de suivre ces évolutions, et le cas échéant de savoir y réagir de manière appropriée. C’est donc bien tout le cycle de vie des modèles d’IA qu’il convient d’adresser, et pas seulement leur conception.

L’ACPR distingue bien ces deux phases de validation : la validation initiale et la validation continue des algorithmes.

Former aux risques et au contrôle

Enfin, concevoir des algorithmes techniquement auditables ne suffit pas, encore faut-il que ces algorithmes soient audités. C’est-à-dire que des procédures d’audit soient définies et des personnes formées.

Ce dernier point soulève notamment la question de l’organisation du contrôle interne et de la formation aux risques liés à l’introduction de l’IA. Dans cette perspective, l’IIA (Institute of Internal Auditors) a également mené ses réflexions sur les évolutions de l’audit interne (3).

Ces bonnes pratiques ne doivent pas être perçues uniquement comme des contraintes réglementaires ; elles permettent d’avoir une meilleure confiance (ou compréhension) dans les résultats d’un algorithme, ce qui a aussi une valeur pour les opérationnels qui les utilisent.

Références :

- le livre blanc de la commission européenne (février 2020)

https://ec.europa.eu/info/sites/info/files/commission-white-paper-artificial-intelligence-feb2020_fr.pdf - le document de travail de l’ACPR sur la gouvernance des algorithmes (juin 2020)

https://acpr.banque-france.fr/sites/default/files/medias/documents/20200612_gouvernance_evaluation_ia.pdf - The Institute of Internal Auditors – Intelligence artificielle – Considérations pour la profession d’audit interne

https://global.theiia.org/translations/PublicDocuments/GPI-Artificial-Intelligence-Part-I-French.pdf