L’analyse de données et le Big Data au service de l’efficacité énergétique : le bâtiment connecté

Le comité stratégique d’ARCSIS m’a invitée en mai dernier au CEA de Cadarache afin de participer à une journée thématique sur le bâtiment connecté en apportant le point de vue de Quantmetry sur l’analyse des données.

ARCSIS (Association pour la Recherche sur les Composants et Systèmes Intégrés Sécurisés) regroupe des grandes entreprises (STMicroelectonics, Gemalto, Air Liquide Balazs, …), des PME et startups (Neowave, ARD, …), ainsi que des laboratoires de recherche (CEA-TECH, INRIA, …), des universités et des collectivités territoriales. Sa mission est d’encourager, accompagner et promouvoir la filière microélectronique et objets communicants en région PACA au niveau national et international. Elle centralise des programmes de R&D et s’associe au pôle de compétitivité mondial Solutions Communicantes Sécurisées.

Après une visite très intéressante de la cité des énergies du CEA (centrale solaire thermique, bâtis expérimentaux à énergie positive et tests de matériaux innovants, réacteur de production d’énergie par la biomasse), le comité stratégique s’est réuni pour un certain nombre de présentations autour des bâtiments connectés. Divers projets ont été présentés par des grandes entreprises comme Schneider Electrics ou IBM, ainsi que par des PME et startups. J’ai moi-même présenté une vision des bâtiments connectés autour de la collecte et l’analyse des données. Cette vision est exposée ici, complémentée d’informations recueillies lors de cette journée.

EFFICACITÉ ÉNERGÉTIQUE DES BÂTIMENTS CONNECTÉS

Selon l’agence internationale de l’énergie, la demande mondiale en énergie augmenterait de 37% d’ici 2040 .

Parallèlement, l’urbanisation croissante et la digitalisation des échanges amèneront les villes à jouer des rôles de leaders dans la révolution énergétique ; il leur faudra relever des défis importants en terme de surveillance, de gestion des réseaux, de l’offre et de la demande en énergie. Cela conduit au concept d’Enernet et de « Energy Cloud » où la gestion et la production de l’énergie sont décentralisées, d’où l’importance d’un mix énergétique bien géré à toutes les échelles. Allant dans ce sens, le parlement européen a demandé le remplacement des compteurs d’électricité par des compteurs communicants (voir Linky) d’ici 2022. Le projet pourrait représenter une dépense de l’ordre de 100 milliards de dollars.

On parle aujourd’hui de smart grids et de « centrales électriques virtuelles » (Virtual Power Plant) : des systèmes intégrant tous les types de sources dans un cluster de générateurs distribués, ainsi que des capteurs multiples remontant des données sur l’offre et la demande, permettant ainsi d’optimiser les diverses sources d’énergie.

La première étape dans cette gestion décentralisée de l’énergie est le bâtiment intelligent et connecté. Il permet d’adopter des solutions efficaces de gestion en installant des capteurs et compteurs connectés, de jouer sur la qualité du bâti (isolation, inertie thermique, étanchéité, etc.), le choix des équipements (production d’énergie, distribution, rendement) et de penser en terme d’efficacité énergétique active (optimisation, lutte anti-gaspillage, sensibilisation des usagers). Aujourd’hui déjà, on sait atteindre des gains de 30 à 60% sur la consommation des bâtiments y compris sur les bâtiments faiblement intermittants comme les hôpitaux, les résidences ou les datacenters. Cette efficacité énergétique est un enjeu économique majeur car elle implique des retours sur investissements rapides de l’ordre de un à trois ans.

La seconde étape implique la gestion de la communication des bâtiments non pas en silo, mais de façon interconnectée et multi applicative, afin d’être capable d’isoler des quartiersentiers de la grille pendant plusieurs heures grâce à une autonomie énergétique finement optimisée, et à terme, de construire des quartiers à énergie positive.

Le quartier connecté amène à la dernière étape dans la gestion énergétique des villes qui concerne la résilience des systèmes. L’interconnection permet de gérer les crises après des tornades, des sinistres graves, ou des usages critiques et d’améliorer la capacité du système à se remettre en marche. Le réchauffement climatique et l’urbanisation des populations montre combien il est crucial de penser dès aujourd’hui la résilience de nos villes : les crises seront de plus en plus fréquentes et répandues.

Aujourd’hui, la première étape se met en place dans les villes pilotes, les nouveaux bâtiments et la réhabilitation d’anciens bâtiments, en particulier des bâtiments publics. Le grand public, via l’Internet des objets devient de plus en plus sensible à la problématique. Les promoteurs et les particuliers prennent aussi l’initiative pour connecter les bâtiments. Avec les compteurs connectés, de plus en plus répandus, le secteur de l’énergie est probablement le plus en avance dans la connexion des bâtiments. Certaines expérimentations se font également pour avancer sur la seconde étape du quartier connecté, et les villes et collectivités territoriales élaborent les stratégies du futur pour atteindre la troisième étape à une horizon plus lointaine.

L’industrie est déjà opérationnelle dans la construction de capteurs et des logiciels associés ;les groupes français et européens sont largement représentés dans le secteur commeSchneider Electric, Somfy, Legrand, Hager. Ce mouvement implique des acteurs à tous les niveaux : grands groupes comme PME et TPE. Scara et Cie est une entreprise familiale qui s’est spécialisée dans la domotique, notamment au service de l’efficacité énergétique. Récemment, à l’office de tourisme d’Embrun qui occupe une église du XIVème siècle: avec un investissement limité et sans toucher au bâtiment, classé monument historique, ils ont installé de nombreux capteurs mesurant la température, la luminosité, l’hygrométrie, les taux de CO2 et de CO. La combinaison d’un système d’optimisation automatisé et de prévention auprès des occupants a permis d’atteindre 35 à 38% d’économie d’électricité sur une année. De nombreuses initiatives telles que celle-ci sont de plus en plus médiatisées et l’accélération du mouvement est bien plus aujourd’hui une question d’investissement et de volonté politique qu’une problématique technique.

De plus en plus de solutions logicielles existent pour centraliser les données de plusieurs bâtiments. Intent Technology , l’une des startups du Village by CA, est spécialiste de ces solutions logicielles.

L’enjeu est de faciliter la récupération des données afin de les rendre accessibles après des opérations de transformation pour les exploiter. En effet, beaucoup de bâtiments sont déjàconnectés, mais la collecte des données est difficile et coûteuse. Les constructeurs ont chacun leur langage propre et les normes sur les capteurs et les protocoles de communication ne sont pas encore totalement établies. IntentOS, la solution logicielle d’Intent est vue comme un PaaS (Platform as a Service) et permet l’accès aux données de capteurs sur un grand parc de bâtiments afin de valoriser ces données. Si la pose de capteurs est déjà utile au niveau d’un bâtiment individuel pour permettre l’optimisation de la consommation d’énergie avec des gains importants, on ne pourra vraiment exploiter tout le potentiel du bâtiment connecté que dans l’interconnexion des systèmes.

L’ANALYSE DE DONNÉES POUR UNE CONNAISSANCE FINE DE LA DEMANDE ET DE LA CONSOMMATION

Avant les compteurs communicants, les compteurs étaient relevés quelques fois par an par un technicien d’EDF ou de GDF. Cela ne permettait pas d’avoir une vision fine de la consommation indivuelle d’un bâtiment car la fréquence de relève était extrêment basse. Au niveau d’un quartier ou d’une ville, les données de consommation était relevées à une fréquence plus élevée, mais de façon très agrégée. D’autre part le coût de stockage des données était très élevé. Des modèles prédictifs de consommation d’énergie existaient mais très difficiles à paramétrer de part le manque de données massives et la faible capacité de calcul. On n’avait donc qu’une connaissance limitée des phénomènes locaux, avec un pouvoir prédictif faible.

Aujourd’hui, les coûts de stockage faibles et la mise en place de multiples capteurs à tous les niveaux nous amènent à l’ère du Big Data dans le domaine du bâtiment et de la consommation d’énergie. On peut mettre en place des systèmes d’analyse de données qui permettent une connaissance fine des bâtiments et de leur consommation.

DES SYSTÈMES D’ANALYSE COMPLEXES, DÉPLOYÉS SUR PLUSIEURS ÉCHELLES

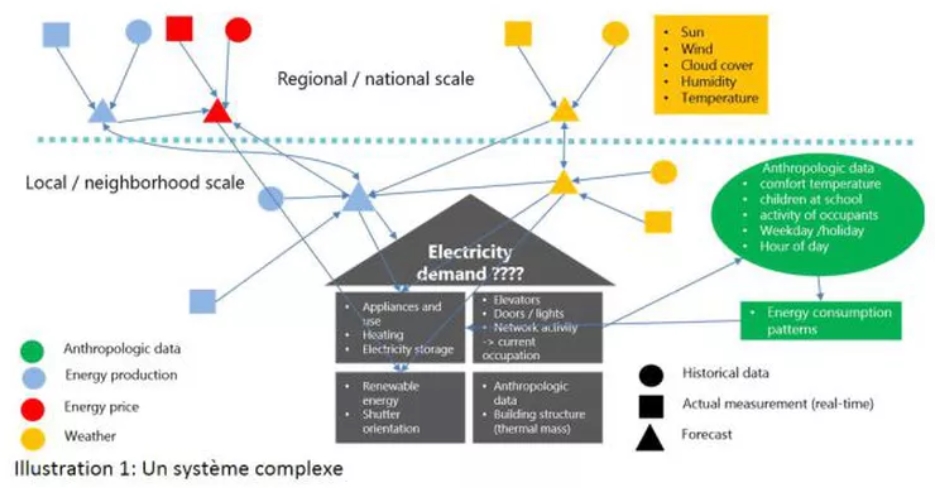

Au delà du défi de la collecte et du stockage de ces données massives, un défi de taille est bien la mise en place de systèmes d’analyse. Pour prédire finement la consommation d’énergie d’un bâtiment, il faut croiser un nombre important de données : la liste des équipements installés, des données anthropologiques comme la température de confort des habitants, leur activité (actifs, retraités, étudiants, artisans), le nombre d’enfants, etc. Un système d’analyse locale permet d’apprendre les habitudes de consommation des habitants en se basant sur l’historique des données et de prédire la consommation en temps réel. En revanche, un tel système ne peut être réellement précis et efficace que s’il est alimenté par d’autres systèmes externes situés hors du bâtiment. Il est indispensable de fournir des prédictions de météo locale au modèle prédictif de la consommation du bâtiment individuel ; ces prédictions météo doivent s’appuyer sur l’historique des données locales (ensoleillement, vent, couverture nuageuse, humidité, température, topologie du terrain, …) mais aussi sur autre système prédictif à une échelle régionale capable de prédire la météo à plus long terme.

Les phénomènes d’échelle contraignent les systèmes et impliquent l’interconnexion de modèles génériques à grande échelle avec des modèles spécialisés à l’échelle locale. De même pour la production d’énergie : on peut connaître à l’avance la production à l’échelle nationale ou régionale de façon précise car il s’agit d’une production globale et massive par de grandes unités (centrales hydroélectriques, nucléaires, thermiques). En revanche à une échelle plus fine et locale, les EnR (énergies renouvelables) comme les panneaux solaires ou les éoliennes induisent des fluctuations importantes que l’on peut prédire avec un modèle se basant sur l’historique de production et un modèle prédictif de la météo locale.

La boucle est presque bouclée en branchant les systèmes de prédiction de production d’énergie au niveau local avec un système de calcul du coût de l’énergie sur le marché à un instant donné. De cette façon, on peut optimiser la consommation des bâtiments en faisant fonctionner certains équipements gourmands au moment où le coût de l’énergie est plus faible ou en induisant le stockage de l’énergie dans des batteries comme celles des véhicules électriques par exemple. Cette optimisation automatique devra être ajustée en fonction des habitudes et des préférences des occupants : on ne souhaite pas démarrer une machine à laver en partant au travail alors que le retour ne se fera que tard le soir.

DES CAPTEURS PARTOUT ?

Pour affiner les calculs, le système d’optimisation de consommation du bâtiment connecté peut être alimenté par un système de calcul du taux d’occupation à un moment donné. Il est tentant d’installer des capteurs en nombre dans toutes les pièces comme des capteurs de présence par exemple. Plus simplement, on peut compter le nombre d’entrées et de sorties par les portes d’accès au bâtiment ou le taux d’utilisation des ascenseurs. Dans ce cas, le taux d’occupation est approximatif, et il est probable de devoir corriger un biais de temps à temps. Néanmoins, il n’est pas nécessaire d’avoir une connaissance exacte du nombre d’occupants à un moment donné pour être précis sur la consommation car l’information importante est dans la variation relative plutôt que dans le chiffre absolu. On économise sur le coût d’équipement du bâtiment et sur la consommation électrique des capteurs et leur maintenance qu’il faut prendre en compte globalement dans le système d’optimisation.

Plus généralement, l’interconnexion des données des bâtiments connectés permet d’éviter de connecter tous les équipements. On peut créer des modèles capables d’inférer les données manquantes ou de corriger les erreurs des capteurs par similarités : des équipements similaires installés dans un contexte semblable ont toutes les raisons de fonctionner de la même façon. On a ainsi tout intérêt à mutualiser les données pour avoir une connaissance plus riche et une capacité à généraliser d’un équipement à l’autre.

BEAUCOUP DE CAS D’USAGE

Outre la prédiction et l’optimisation énergétique, les capteurs installés dans les bâtiments sont utiles pour beaucoup de cas d’usage avec des bénéfices importants en terme sociaux, de confort et de sécurité des

D’autre part, les autorités publiques et les assureurs se mobilisent pour faire face aux situations de détresse chez les populations à risque, et cherchent à les anticiper et les gérer le plus rapidement possible. La détection de la maladie d’Alzheimer chez les personnes isolées est une problématique très critique et le vieillissement de la population accroît son importance. L’analyse des données de consommation permet de détecter des anomalies énergétiques causées par des oublis répétitifs : des plaques électriques allumées ou un robinet ouvert trop longtemps par exemple. Une alerte suite à de telles anomalies peut être envoyée aux proches et aux gardiens d’immeuble. La détection de chutes chez les personnes agées, les situations de détresse lors de vagues de chaleur de plus en plus fréquentes, sont aussi des problèmes que les autorités et les assureurs cherchent à résoudre à l’aide de la pose de capteurs. Il ne s’agit pas de remplacer le lien social et l’accompagnement des personnes, mais l’important est d’agir vite en cas de détresse, et c’est ce que l’installation de capteurs peut améliorer.

En terme business, l’analyse et l’agrégation des données permettent une segmentationclient des populations pour adapter les offres de service. Ces segmentations peuvent être mutualisées par les différents acteurs qui ont des points de vue différents sur les habitudes des populations (fournisseurs d’électricité, de gaz, d’eau, FAI, espaces verts et jardins, fournisseurs et opérateurs d’équipements comme les ascenseurs, les systèmes de surveillance, etc.).

La maintenance prédictive est encore un cas d’usage particulièrement important pour le bâtiment connecté, avec un retour sur investissement incontestable en terme de réduction des coûts. Certains équipements comme les ascenseurs sont très sollicités et sont parfois critiques (hôpitaux, bâtiments publics, maisons de retraite). Actuellement, la maintenance est très largement curative ou préventive, avec des réparations et des révisions régulières. Le coût est important car la priorisation des interventions de maintenance est difficile à établir. Les techniciens sont mobilisés sur des révisions pour constater que l’équipement fonctionne correctement ou a des défauts mineurs, tandis que des pannes critiques surviennent à des moments de forte sollicitation sur d’autres équipements.

Quantmetry travaille actuellement sur des projets de maintenance prédictive, et nous publierons bientôt des posts sur ce sujet. Les systèmes d’analyse de données pour la maintenance prédictive impliquent des techniques de machine learning bien adaptées, et une architecture de modèles particulière en fonction des besoins métiers et des problématiques opérationnelles qu’il est intéressant de détailler avec des exemples concrets.

THE BIG (DATA) PICTURE

Connecter les bâtiments est une initiave d’utilité publique car les gains sont importants en terme d’efficacité énergétique et de réduction des coûts financiers et sociaux.

Le Big Data et l’analyse de données a un rôle central et innovateur à jouer dans ce mouvement. On y retrouve tous les Vs du Big Data :

-

le volume : le nombre de bâtiments et de systèmes à connecter et interconnecter est immense et croissant ;

-

la vitesse :une réelle optimisation des systèmes implique une réactivité importante à tous les niveaux (production, prédiction, détection, action) et des boucles de rétroactivités complexes demandant des traitements rapides de l’information ;

-

la variété : beaucoup de sources de données très différentes sont nécessaires pour des prédictions précises et une bonne optimisation (données climatologiques et météorologiques, production et consommation d’énergie à différentes échelles, données économiques, sociales, sociologiques, d’activités et de comportements sociaux, données caractéristiques et techniques d’équipements très variés, …)

-

la véracité : elle doit être prise en compte à toutes les échelles dans les systèmes d’analyse avec des systèmes de correction de biais, de détection d’erreurs et d’anomalies, de gestion de données manquantes ou imprécises.

Comme nous l’avons mentionné plus haut, il est également important de considérer les choses dans leur ensemble : un bâtiment connecté seul relève du gadget amusant mais peu utile. L’optimisation énergétique et l’apprentissage sur les besoins et les habitudes ne peuvent se faire qu’avec une vision globale et avec la mise en place progressive de systèmes physiques interconnectés et à plusieurs échelles géographiques (individuelle, locale, régionale et continentale) et temporelles (temps réel, heure, jour, mois, années et données historiques).

Il est donc nécessaire d’adopter une stratégie adaptée pour interconnecter correctement les systèmes logiciels de collecte et de stockage. Il faut savoir exploiter toutes les possibilités offertes par les technologies modernes du Big Data et les choisir en adéquation avec les besoins.

Certaines données « chaudes » nécessitent un stockage « orienté sur les transactions » avec une écriture rapide et répétitive de données peu volumineuses comme les logs par exemple. Teradata, HBase et Cassandra sont des exemples de technologies adaptées à ce cas. D’autres données très volumineuses, comme des données vidéos par exemple, ou des données plus « froides », comme les données de contrat client, nécessitent des technologies « orientées sur le stockage massif », comme Hadoop. Des technologies dites « orientées streaming » comme Storm, Kafka, Spark Streaming et Flink permettent de gérer les flux « temps réel » et des calculs à la volée. Les systèmes de calculs de haute performance (high performance computing ou HPC) permettent d’opérer des calculs très gourmands en ressources CPU ou GPU, et de résoudre des problèmes complexes (reconnaissance d’image, prédictions avec boucles rétroactives multiples, etc.). Enfin des technologies plus hybrides comme Spark, Impala, SQL interactive, Tez sont des compromis entre les besoins en stockage, vitesse et performance, et peuvent permettre d’interfacer les différentes solutions logicielles très spécialisées.

Il en va de même pour les systèmes d’analyse de données. Une équipe de data scientists au fait des techniques de modélisation et d’intelligence artificielle peut développer un système autosuffisant de prédiction de consommation énergétique pour un bâtiment donné, si les données à leur disposition sont de bonne qualité et suffisamment variées pour rendre compte des divers phénomènes impliqués.

Néanmoins, un tel cas est quasiment utopique et ne se présente que très rarement dans les conditions réelles. De fait, les données sont souvent de qualité très variable et sont la plupart du temps très partielles. Aussi, avant la construction d’un modèle prédictif, il est indispensable d’implémenter des systèmes de correction d’erreurs sur les données de capteurs (gestion des biais, normalisation entre les capteurs, détection et correction des valeurs abérantes), des systèmes de remplacement de données manquantes (par inférence statistique, similarités), et d’enrichir les données avec des sources externes provenant d’autres capteurs ou d’autres systèmes prédictifs.

D’autre part, les normes sur les protocoles de communication des capteurs et sur la forme des données ne sont pas encore en place, et la bataille des standards a commencé. Ces données non harmonisées complexifient beaucoup les tâches d’analyse. Enfin, certains équipements complexes possèdent des systèmes logiciels embarqués en charge d’agréger les données avant transmission. Le développement de ces logiciels embarqués dépend des constructeurs et l’agrégation n’est pas toujours adaptée aux besoins en aval, après transmission.

Les équipes de data scientists doivent savoir maîtriser les différents types et niveaux de modèles statistiques et prédictifs, les techniques de reconstruction de données et l’interfaçage de ces composants en un système global complexe, tout en utilisant les technologies Big Data adaptées.

Une bonne vue d’ensemble et une planification bien pensée permettra aussi d’adopter une approche pragmatique. Il est tentant de tout vouloir connecter tous les équipements et de poser des capteurs dans chaque pièce habitée. Les constructeurs, les revendeurs et les entreprises de service pousseront naturellement le mouvement en ce sens. Cela n’est pas toujours nécessaire car il est possible de mettre en place des systèmes de reconstruction de données. Inutile de connecter chaque cafetière pour connaître la consommation d’un bâtiment de façon satisfaisante. La cafetière connectée est un gadget amusant mais totalement inutile pour l’optimisation énergétique et surtout très coûteux en énergie et en bande passante. Aujourd’hui, plusieurs acteurs du secteur énergétique savent déjà reconstruire les données de consommation de des équipements principaux d’un bâtiment en analysant uniquement la consommation globale du bâtiment, à condition que les données soient collectées à une fréquence suffisante.

L’innovation et les cycles de développement dans les capteurs, les technologies Big Data et les techniques d’analyse de données et de prédiction sont bien plus rapides aujourd’hui qu’il y a une vingtaine d’années. Aussi, les ingénieurs du Big Data, les data scientists, mais également les donneurs d’ordre doivent en permanence se tenir au courant des dernières évolutions et consulter les experts. La tension croissante sur la demande en énergie et en services, la protection des données personnelles, un enjeu majeur pour le bâtiment connecté, et la lutte contre le terrorisme et la cybersécurité rendent les mises à jour des systèmes absolument critiques et indispensables.

UNE COLLABORATION DE TOUS LES ACTEURS

La mise en place progressive des systèmes doit donc faire intervenir des acteurs constamment et à tous les niveaux : adéquation, interconnection, sécurité des équipements et des logiciels, protection juridique, sûreté des systèmes et du territoire, mise en place et interconnection des couches logicielles de calcul à diverses échelles.

Une collaboration entre les autorités de régulation, les pouvoirs publics, les constructeurs, les opérateurs, les équipes de techniciens, les différentes équipes d’ingénieurs Big Data qui collectent, traitent et stockent les données, les data scientists qui les analysent, et enfin les utilisateurs finaux (bailleurs, syndics, gestionnaires et particuliers) est absolument indispensable afin d’établir progressivement des normes techniques et juridiques et des standard ouverts, suffisament harmonisés pour faciliter le travail à toutes les étapes, et suffisament souples pour permettre de prendre en compte les multiples applications et les cas d’usage futurs.

Le bâtiment connecté et les smart grids sont aujourd’hui des secteurs innovants et en construction. Il est prématuré d’adopter une stratégie globale et une plannification figée. La mise en place et l’évolution des systèmes sera très complexe et très progressive. Les normes et les processus devront être décidés de façon souple et adoptés au fur et a mesure, autour d’un écosystème en perpétuelle évolution et extrêmement contraint. La seule manière de parvenir à un contrôle et une souplesse satisfaisante est la collaboration de tous les acteurs, bi- ou tri-latérales dans un premier temps, au travers de projets innovants, puis de manière multilatérales, lorsque suffisamment d’expérimentations auront été menés pour fournir une connaissance plus globale, tirer des conclusions et prendre les décisions adaptées. Il est important d’y réfléchir dès aujourd’hui.