Vers un standard d’évaluation des dispositifs médicaux embarquant de l’IA

✍ Gill Morisse et Guillaume Hochard / Temps de lecture : 7 minutes.

Comment évaluer des dispositifs médicaux intégrant de l’intelligence artificielle et faciliter leur mise sur le marché ? Retour sur la consultation menée par la Haute Autorité de Santé et à laquelle Guillaume Hochard a contribué.

Au cours de l’été 2019, Guillaume Hochard, senior expert data scientist, a été contacté par la Haute Autorité de Santé pour apporter son expertise dans le cadre de la première évaluation d’un dispositif médical embarquant un algorithme d’intelligence artificielle.

Afin de mener cette consultation, Guillaume Hochard avait besoin de produire un cadre méthodologique pour justifier l’évaluation. Certes, il disposait de cadres méthodologiques d’évaluation d’algorithmes apprenants réalisés dans d’autres contextes (due diligences auprès de fonds d’investissement notamment), mais aucun n’était parfaitement adapté à l’évaluation d’un dispositif médical. Guillaume Hochard a donc mis au point une grille d’évaluation afin de permettre à la HAS d’obtenir de la part du fabricant les informations essentielles à une évaluation scientifique de l’intelligence artificielle.

A la remise du rapport d’expertise, la HAS s’est rapidement emparée de cet outil et a souhaité lancer un appel à contribution public pour bâtir un socle d’évaluation de dispositifs médicaux intégrant de l’IA.

Pour bien comprendre l’aspect à la fois innovant et unique de cette démarche, revenons un peu sur le contexte bouillonnant de la E-Santé en France et dans le monde.

L’intelligence artificielle en santé, un mariage difficile, de gros enjeux règlementaires

Le 11 avril 2018, la Food and Drug Administration américaine (FDA) avait donné son feu vert pour la mise sur le marché d’un premier dispositif médical (IDx-DR) utilisant de l’intelligence artificielle et qui permettait d’automatiser la détection de la rétinopathie diabétique à partir de clichés du fond de l’oeil. Cette autorisation suivait l’homologation d’intelligences artificielles comme Cardiologs (analyse ECG) ou Icobrain (suivi de la progression de maladies SEP, trauma crânien et démence à partir d’IRM et scanner). Si d’autres dispositifs médicaux ont bien suivi, on note néanmoins que la vague d’intelligences artificielles promise dans le secteur médical tarde encore à se concrétiser. Et le scandale Theranos aura participé à initier une forme de gestion prudente (et plutôt salutaire?) par les autorités américaines et Européennes. De 2003 à 2018, cette start-up de la Silicon Valley a en effet berné investisseurs et régulateurs en promettant une technologie basée sur de l’intelligence artificielle et permettant de réaliser des tests sanguins peu coûteux.

Malgré le volontarisme affiché par les gouvernements, le marché se heurte encore à de nombreuses difficultés. La rencontre de deux mondes, celui de l’intelligence artificielle et celui du médicament n’est pas un mariage facile ; d’un côté le temps long de l’analyse, la prudence scientifique qui fonde la preuve sur l’analyse de données minutieusement récoltées via des essais cliniques ; de l’autre l’intelligence artificielle qui exploite des données de vie réelle, modifie profondément la pratique médicale et qui s’appuie sur de nouvelles technologies computationnelles mouvantes.

Face à cette nouvelle donne, les autorités régulatrices du monde entier (la Chine étant un cas à part) tardent à se positionner, s’appuyant sur l’avis d’experts mais sans se doter d’un cadre réglementaire qui permette véritablement de standardiser les règles d’accès au marché. Cette incertitude constitue aujourd’hui la principale barrière à l’innovation et à l’investissement de la part des acteurs de la santé (Institutions, Start-ups, ONG, Laboratoires pharmaceutiques…). On retarde aujourd’hui la capacité de solutions innovantes à être mises à disposition des patients, faute d’un cadre méthodologique commun qui garantisse tout à la fois sécurité et gain thérapeutique. Il y a donc urgence.

Des enjeux technologiques à la hauteur des risques

Rappelons que les grands enjeux et challenges autour de l’IA dans d’autres domaines (administration publique, banque, assurance..) se retrouvent de manière particulièrement aiguë dans le secteur de la santé. Et ces enjeux sont à la hauteur des risques : risque clinique, risque financier pour la solidarité nationale, risque de confiance (problématique de performance, de gouvernance et de protection des données de santé, de l’interprétabilité), dans un contexte où l’effet buzz-word peut amener de la confusion à la compréhension des techniques employées : comment faire pour que le patient et les professionnels de santé ne soient pas trompés par la nature des algorithmes embarqués dans les dispositifs? S’agit-il de systèmes experts, déterministes, ou des modèles apprenants?

Les questions de représentativité de la base d’apprentissage, des problèmes de biais de sélection, et des capacités de généralisation du modèle sont au centre des préoccupations du législateur. Exemple qui a récemment défrayé la chronique, le biais de genre dans le modèle de paiement d’Apple Card, suspecté par David Heinemeier Hansson (créateur de Ruby on Rails), a sérieusement entamé le capital confiance autour de ce produit. Le fait qu’Apple soit dans l’incapacité d’expliquer et de prouver l’absence de biais renforce l’idée de la nécessité d’avoir des IA explicables. Pour s’en convaincre, le fabuleux livre de Cathy O’Neil, Weapons of Math Destruction, viendra d’autant plus renforcer cette prise de position, qui fait débat aujourd’hui dans le monde de l’intelligence artificielle.

L’interprétabilité du modèle est un élément important pour le législateur, le professionnel de santé et le patient, pour lever l’effet boîte noire souvent associé à tort aux algorithmes d’IA, dont beaucoup sont interprétables par nature, ou par le biais de techniques spécifiques (voir pour cela notre livre blanc “IA explique toi!”.

Les risques de dérive dans le temps et de maintien de la performance du dispositif sont également essentielles, compte tenu des enjeux vitaux autour de ces dispositifs. Pour en savoir plus sur la dérive des modèles, vous pouvez retrouver nos convictions sur le sujet dans notre livre blanc “IA en production”.

Les régulateurs sont conscients du problème mais les zones d’ombre subsistent

Bien entendu, les régulateurs sont conscients de ces risques et la FDA a récemment annoncé travailler sur un nouveau cadre règlementaire. La FDA a notamment publié en avril 2019 un guide permettant d’ébaucher un standard pour la prise en compte d’intelligences artificielles dites “évolutives”. Ce document très détaillé définit notamment la manière dont les fabricants doivent assurer la surveillance des dispositifs médicaux dotés d’IA et mettre en oeuvre un processus de gestion des risques liés à la sécurité des patients. La FDA attend notamment que les fabricants fassent preuve de transparence envers les utilisateurs et la FDA au moyen de rapports sur la performance du produit en situation réelle et après sa commercialisation, afin d’en garantir la sûreté et l’efficacité.

Il n’en reste pas moins que de nombreuses zones de floue subsistent, notamment sur l’essentiel à savoir la précision de la modélisation mathématique (maîtrise des biais, interprétabilité…), l’échantillonnage du jeu d’apprentissage, la qualité de la donnée utilisée, la stratégie de réentrainement des modèles, l’interprétabilité… Autant de points clés qui restent encore à la libre appréciation des fabricants.

En conférence de presse, le 20 novembre 2019, Isabelle Adenot, présidente de la Cnedimts (Haute Autorité de Santé) a ainsi déclaré :

« A ma connaissance, aucun pays n’a développé une telle grille (nda : grille d’évaluation des dispositifs médicaux embarquant de l’IA), qui explique comment on va évaluer, et pas seulement ce que l’on va évaluer ».

« Pour favoriser la diffusion de l’innovation et permettre aux industriels de préparer leur dossier, ils doivent savoir ce qui va être évalué et comment ça va être évalué. Il y a un choc des cultures entre les industriels de l’IA et la HAS: ces acteurs ne sont pas ceux auxquels la HAS est habituée et vice-versa, donc on a parfois du mal à se comprendre », a-t-elle ajouté.

Vers un cadre méthodologique d’évaluation standard des dispositifs médicaux embarquant de l’IA

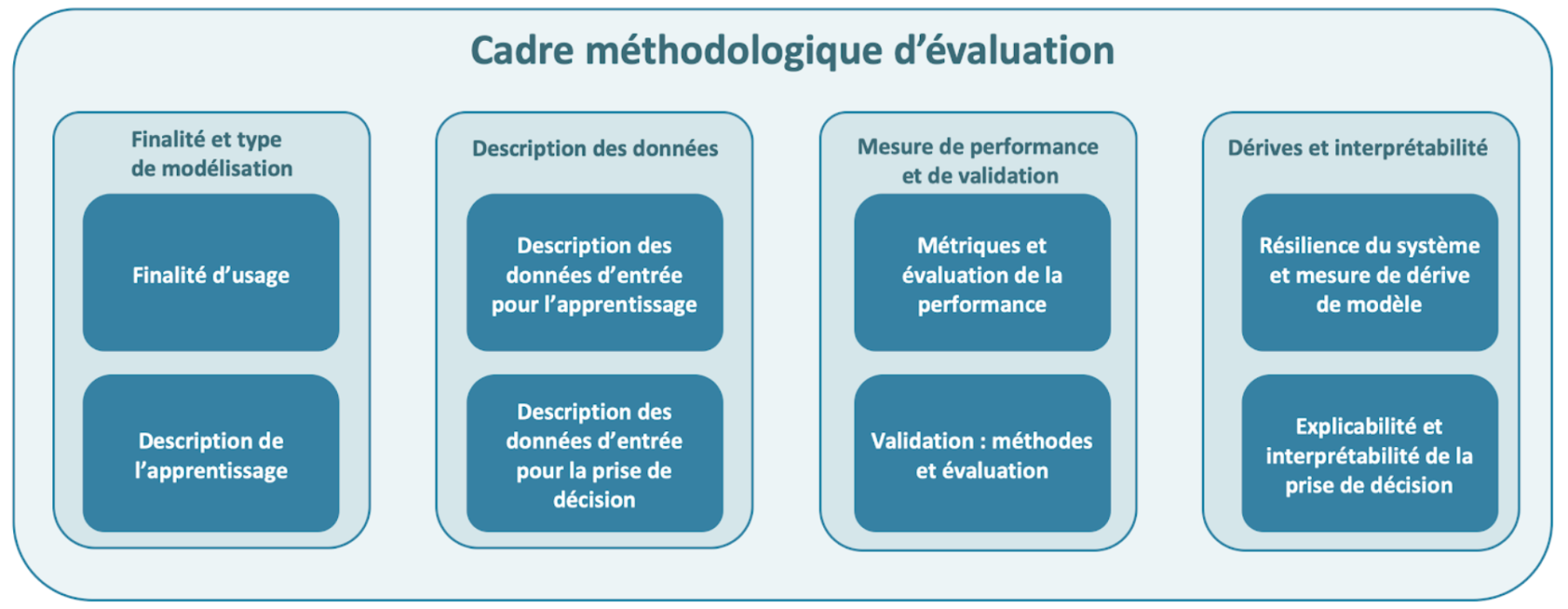

Afin de répondre aux enjeux de l’intégration d’intelligence artificielle et d’algorithmes apprenants dans les dispositifs, Guillaume Hochard a proposé un cadre méthodologique d’évaluation autour de 4 axes regroupant 8 points clés fondamentaux :

- Finalité d’usage et type de modélisation

- Description des données utilisée pour l’apprentissage et pour la prise de décision

- Mesure de performance, capacités de généralisation de l’algorithme et de méthode de validation

- Monitoring des dérives du modèle et interprétabilité/explicabilité de la prise de décision

Cette grille d’évaluation est disponible sur le site de la HAS en pièce jointe de l’appel à contribution publique.

En complément de cette grille, Guillaume Hochard a soumis une grille de notation des différents points qui s’articule autour de trois axes :

- La criticité : ce critère vise à déterminer dans quelle mesure le point évalué est critique pour la sécurité et l’intégrité vitale du patient. Cette méthodologie est largement inspirée des normes DO-178B et ED-12C mises en place dans les logiciels critiques de l’avionique dans l’aviation commerciale et l’aviation général qui précisent notamment les contraintes de développement liées à l’obtention de la certification d’un logiciel d’avionique. Elles incluent 5 niveaux de criticité, allant d’un défaut pouvant provoquer un problème sans effet sur la sécurité du vol à un défaut compromettant la sécurité du vol ou l’atterrissage pouvant entraîner le crash de l’avion.

- Le niveau de preuve : méthodologie déjà appliquée par la HAS décrite dans un document d’avril 2013, le niveau de preuve d’une étude caractérise la capacité de l’étude à répondre à la question posée. Dans ce document, la HAS indique que la capacité d’une étude à répondre à la question posée est jugée sur la correspondance de l’étude au cadre du travail (question, population, critères de jugement) et sur les caractéristiques suivantes : l’adéquation du protocole d’étude à la question posée ; l’existence ou non de biais importants dans la réalisation ; l’adaptation de l’analyse statistique aux objectifs de l’étude ; la puissance de l’étude et en particulier la taille de l’échantillon.

- La qualité de la réponse (est-elle satisfaisante du point de vue du critère à évaluer, incomplète avec nécessité d’apporter des précisions complémentaires, ou non satisfaisante, si le point avait été négligé lors du design du dispositif de santé par exemple). Ce critère vise à faciliter la communication avec les parties (experts, soumissionnaires et législateur) afin d’accélérer les échanges et d’affiner le niveau de détail à apporter lors des échanges.

Le débat public ne porte pas encore sur l’évaluation des différents points de la grille, mais nul doute qu’il sera au centre des préoccupations une fois la grille d’évaluation enrichie et complétée des contributions publiques. Nous ne manquerons pas de revenir, dans un prochain billet de blog, sur la nature de ces contributions, une fois qu’elles auront été analysées, traitées et restituées par la HAS.

Appel à contribution publique : votre participation compte !

La Haute Autorité de Santé appelle l’ensemble des acteurs des deux mondes, celui de l’intelligence artificielle et celui de la santé, à collaborer pour contribuer à écrire ce premier standard d’évaluation. Sur le plan international, ce projet pourrait être un premier pas remarqué vers l’émergence d’une régulation à la fois plus exigeante et plus transparente de l’intelligence artificielle en santé.

Et ne nous y trompons pas, en levant le voile d’incertitude ambiant et en imposant une norme, la France a une carte à jouer dans un contexte concurrentiel comparable à une course aux armements. Nombre de Medtechs françaises, remarquées au CES 2019 et dans les grands rendez-vous internationaux de l’innovation (Implicity, Visible Patient, Moon, Dental Monitoring…) pourraient être avantagées en emboîtant rapidement le pas d’une technologie maîtrisée et directement développée en s’adaptant au niveau d’exigence Français.

Ce standard, en revanche, pour être adopté dans la durée, devrait faire l’objet d’une appropriation par l’ensemble de la chaîne d’évaluation (GMED pour le marquage CE, l’ANSM pour l’autorisation de mise sur le marché et la sécurité des patients). La proposition aujourd’hui sur la table est en effet une grande avancée mais elle ne peut garantir à elle seule la sécurité et la capacité de passage à l’échelle des futurs dispositifs médicaux. La robustesse de l’infrastructure technologique n’est, par exemple, pas abordée. Comment s’assurer que la performance des machines suivra lorsque 100 000 dispositifs seront connectés en même temps ? Idem pour les données personnelles traitées dans le cloud, comment en garantir la complète sécurité ? Et enfin, quel dispositif humain, quelles compétences sont déployés par le fabricant pour maintenir, faire évoluer les algorithmes et l’architecture technologique ? En particulier en un temps où les machine learning engineers se font rares.

Quoiqu’il en soit, en tant que société spécialisée en intelligence artificielle, nous accueillons avec intérêt ce projet et il nous semble sain que nos ingénieurs abordent désormais les sujets médicaux avec un cadre réglementaire exigeant, mais qui nous rappelle que la sécurité et la santé du patient sont primordiaux. Nous sommes par ailleurs plus que jamais mobilisés pour garantir à nos clients, un transfert complet de compétences et un accompagnement pour s’approprier des outils qui ne seront jamais de simples briques logicielles déterministes.

Si vous souhaitez contribuer à cet appel à projet, vous avez jusqu’au 15 janvier pour soumettre vos commentaires.

Quantmetry souhaite remercier tout particulièrement Nicolas Bousquet et Karl Neuberger pour leurs remarques apportées à la relecture de cet article.