Audit interne des IAs : la confiance au coeur de la démarche

Pourquoi réaliser des audits internes IA de confiance ?

Le marché de l’IA : une croissance folle encore incontrôlée

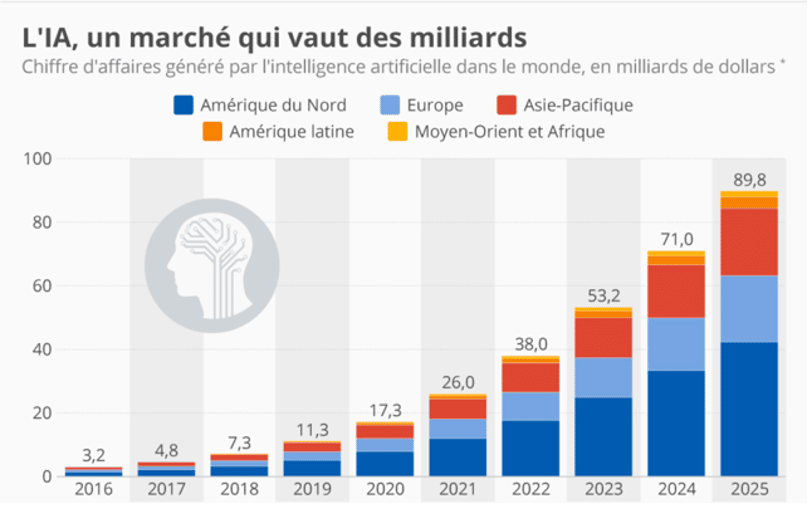

Depuis 2012 et l’avènement du deep learning lors de la compétition ImageNet [1], le marché de l’intelligence artificielle (IA) est en croissance exponentielle [2] (voir figure ci-dessous). Tout le tissu économique s’en imprègne, tant et si bien que nous ne passons plus une journée sans interagir avec une IA, que ce soit celles qui foisonnent dans nos smartphones, sur nos réseaux sociaux, dans les boutiques en ligne ou dans nos boîtes mails.

Figure 1 : Estimation du PIB généré par l’IA dans les années à venir. Source : [2]

En parallèle de cette évolution créatrice de valeur, on observe également une recrudescence exponentielle des scandales et des risques associés à un usage incontrôlé de l’IA. Certaines IAs ont discriminé des femmes sur le marché de l’emploi [3], ont confondu des afro-américains avec des gorilles [4], ont recommandé à des patients dépressifs de se suicider [5], ou ont incité les policiers à accroître les inégalités de surveillance policière [6]. Aujourd’hui, il existe même une base de données publique recensant nombre de scandales liés à l’utilisation incontrôlée de l’IA dans le monde [7].

L’AI Act : un cadre normatif imminent pour les IAs à risque

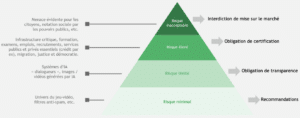

En réponse à cette recrudescence des risques, l’Union Européenne, pionnière en la matière, travaille depuis 2018 sur une proposition de loi visant à réguler les IAs, c’est-à-dire tous les systèmes experts, méthodes statistiques ou modèles de machine learning. Les IAs jugées à risques sont au cœur des préoccupations réglementaires [8] (voir figure ci-dessous). Cette législation a vocation à préserver les citoyens européens et leurs droits fondamentaux, ainsi qu’à créer un terreau fertile à l’innovation en Europe, en alignant les législations des différents pays. Elle s’appliquera à tout acteur, même extérieur à l’Union Européenne, dès lors qu’il déploie une IA risquée sur le territoire européen. Enfin, elle s’appliquera à toutes les intelligences artificielles au sens large, incluant l’apprentissage automatique mais également les méthodes statistiques ou les systèmes experts.

Figure 2 : Les niveaux de risques décrits dans l’AI Act. Source : Quantmetry.

Le texte de loi sera voté de manière imminente, au cours de l’année 2023, et entrera en application dès 2025, sur le même modèle que le déploiement du Règlement Général pour la Protection des Données (RGPD)

L’IA de confiance : un prérequis pour se mettre en conformité

L’émergence de cadres réglementaires tels que l’AI Act répond en réalité à une crise de confiance, et trouve de nombreux échos dans le monde entier (le rapport Villani en France [10], l’Artificial Intelligence and Data Act au Canada [11], les standards du NIST [12] ou encore l’Algorithmic Accountability Act aux Etats-Unis [13]). Les entreprises ayant déjà vécu la transformation du RGPD ont désormais besoin de construire un cadre qui définisse l’intelligence artificielle de confiance, et qui soit une passerelle vers la conformité règlementaire.

A l’instar des secteurs déjà réglementés (banque, aviation), c’est bien une logique de gestion de la qualité que l’on voit se mettre en place chez les acteurs les plus en avance sur le sujet. Dans ce cadre, l’audit interne apparaît comme indispensable pour se mettre en ordre de marche vers la conformité réglementaire et d’améliorer la fiabilité des IAs tout au long de leur cycle de vie.

Plus généralement, la dérive des coûts et des délais liée à la non-qualité des livrables projet, le besoin de transparence pour gagner la confiance des utilisateurs, le besoin d’assurer une opérabilité pérenne des systèmes d’IA, sont autant de raison d’adresser le sujet de l’IA de confiance, qui rime souvent avec excellence.

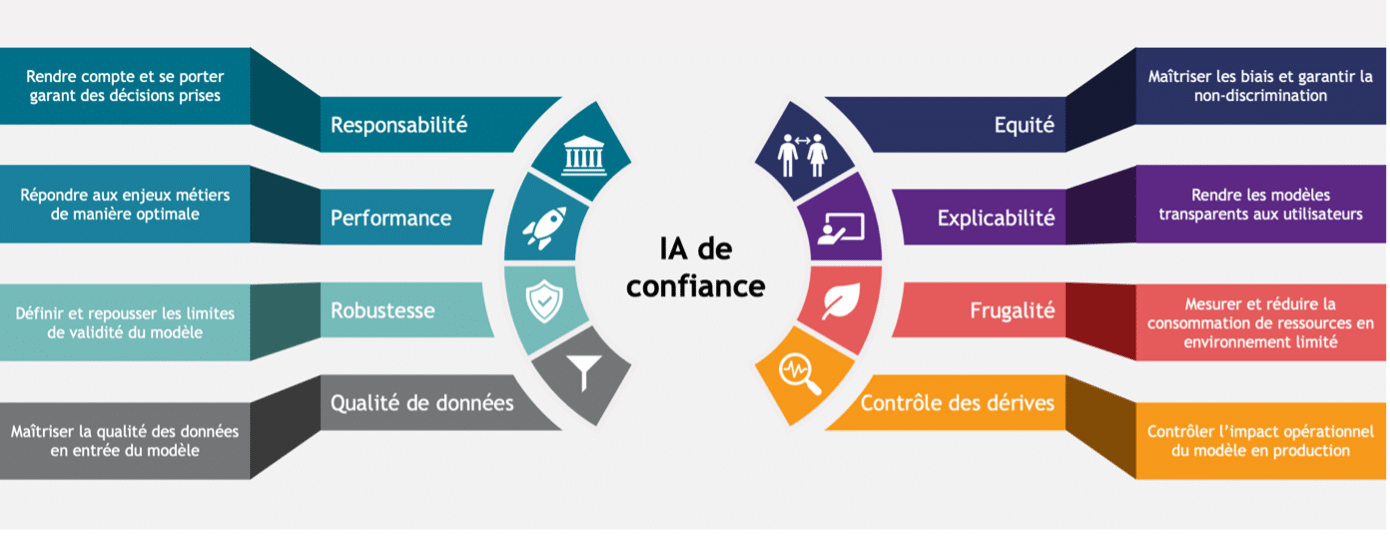

Au sein de Quantmetry, riches de nos 10 années d’expérience en réalisation de projet d’IA de bout-en-bout, et conscients des enjeux stratégiques et réglementaires à venir, nous avons défini l’IA de confiance autour de 8 thèmes principaux (voir figure ci-dessous).

Figure 3 : Les piliers de l’IA de Confiance. Source : Quantmetry.

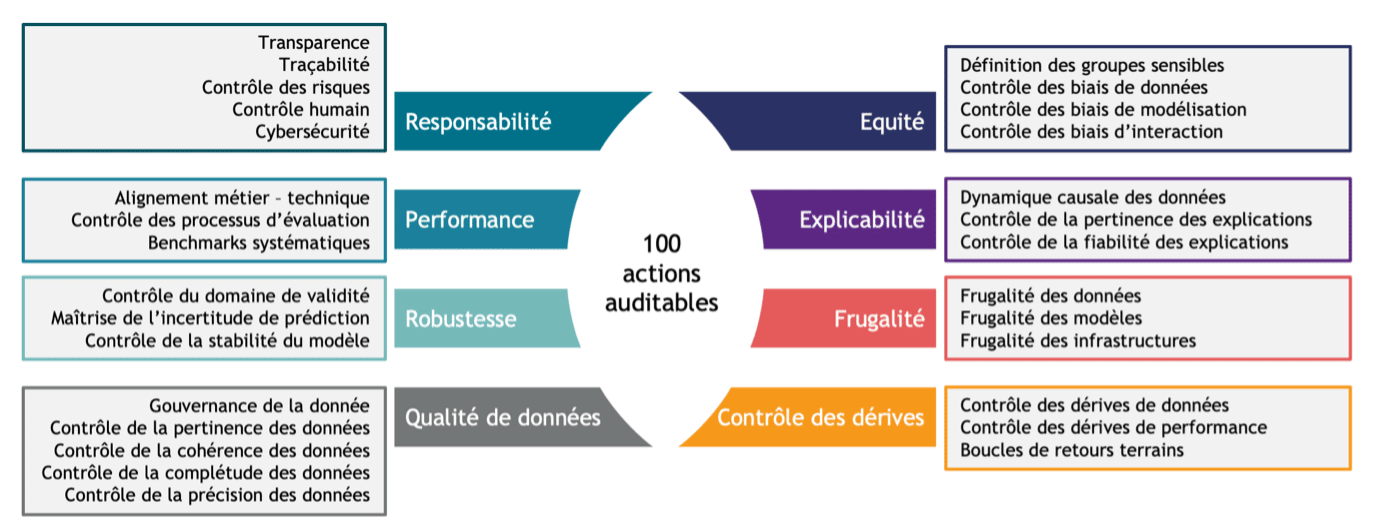

Chacun de ses thèmes regroupe différentes notions plus précises (voir figure ci-dessous), qui constituent la base de notre méthodologie d’audit IA de confiance, décrite ci-après.

Figure 4 : Les sous-thèmes détaillés des différents piliers IA de Confiance. Source : Quantmetry.

Comment régler sa dette en IA de confiance ?

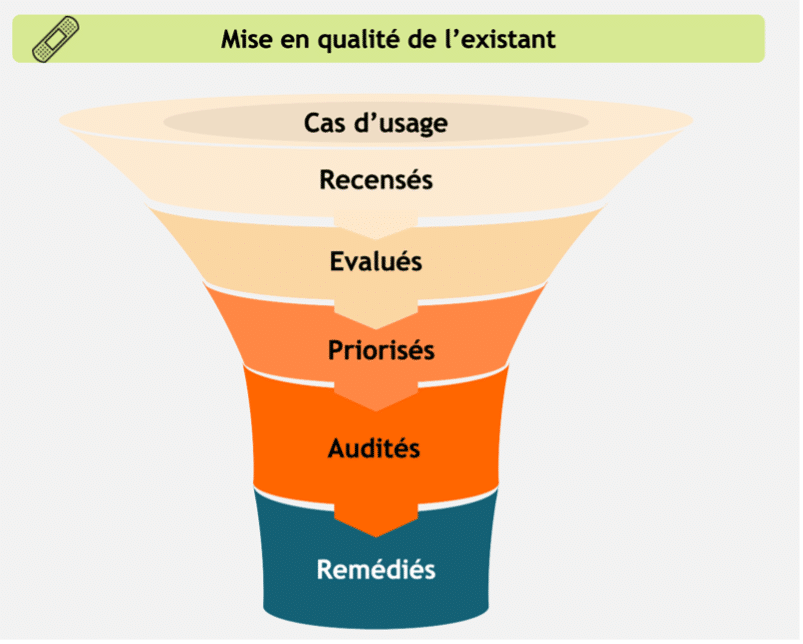

Implémenter l’IA de confiance nécessite de d’abord analyser sa dette, de prioriser ses cas d’usage selon leurs risques, et ensuite de les analyser en profondeur par un audit, avant de les remédier (voir Figure 5).

Figure 5 : Méthodologie de rattrapage de la dette IA de confiance dans une entreprise. Les cas d’usage sont d’abord recensés, puis leur risque est évalué, ce qui permet de les prioriser. L’audit s’applique aux cas les plus risqués, et fournit une feuille de route pour les remédier.

« J’ai beaucoup de cas d’usage IA. Par où commencer ? »

Un audit est un processus qui demande du travail, typiquement plusieurs jours. Par conséquent il faut savoir comment prioriser avant de déclencher le processus d’audit sur des cas d’usage pertinents. Cette priorisation se concentre sur deux types de cas d’usages : les cas d’usages risqués et les cas d’usages stratégiques.

En effet, les cas d’usages risqués sont en général ciblés en vue de la réglementation européenne. Les identifier est la première étape de notre méthodologie.

Quant aux cas d’usages stratégiques, nous accompagnons également nos clients pour définir une politique de priorisation : est-ce que le cas d’usage est en production ? Quelle est sa visibilité ? Quel est le nombre d’utilisateurs actifs à date ? Est-ce que le modèle est accessible à des utilisateurs en dehors de l’organisation ? Quel est le coût d’une erreur ? Selon ces différentes analyses, les cas d’usages sont priorisés afin de s’assurer qu’ils répondent bien à l’ensemble des critères de l’IA de Confiance pour limiter les risques financiers ou réputationnels les concernant.

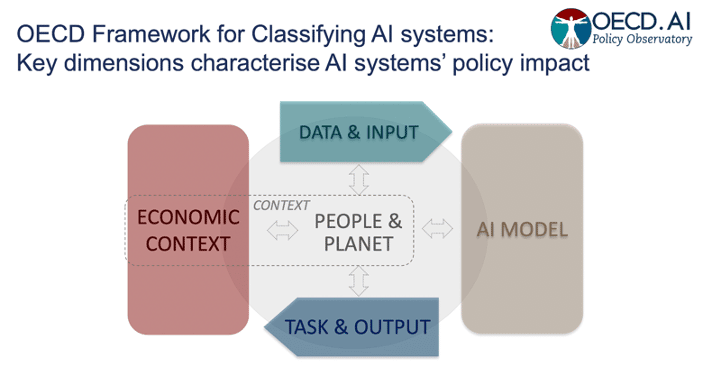

Notre méthode d’évaluation des risques des IAs se fonde sur les travaux de l’OCDE [14]. Ce cadre de travail remet en contexte cinq notions différentes afin de mesurer le niveau de risque d’une IA.

Figure 6 : Les dimensions prises en compte dans l’évaluation du risque des IAs, telles que définies par l’OCDE. Les « input » correspondent aux entrées du modèle (données, paramètres), et les « output » aux sorties (prédictions, recommandations). Source : [14]

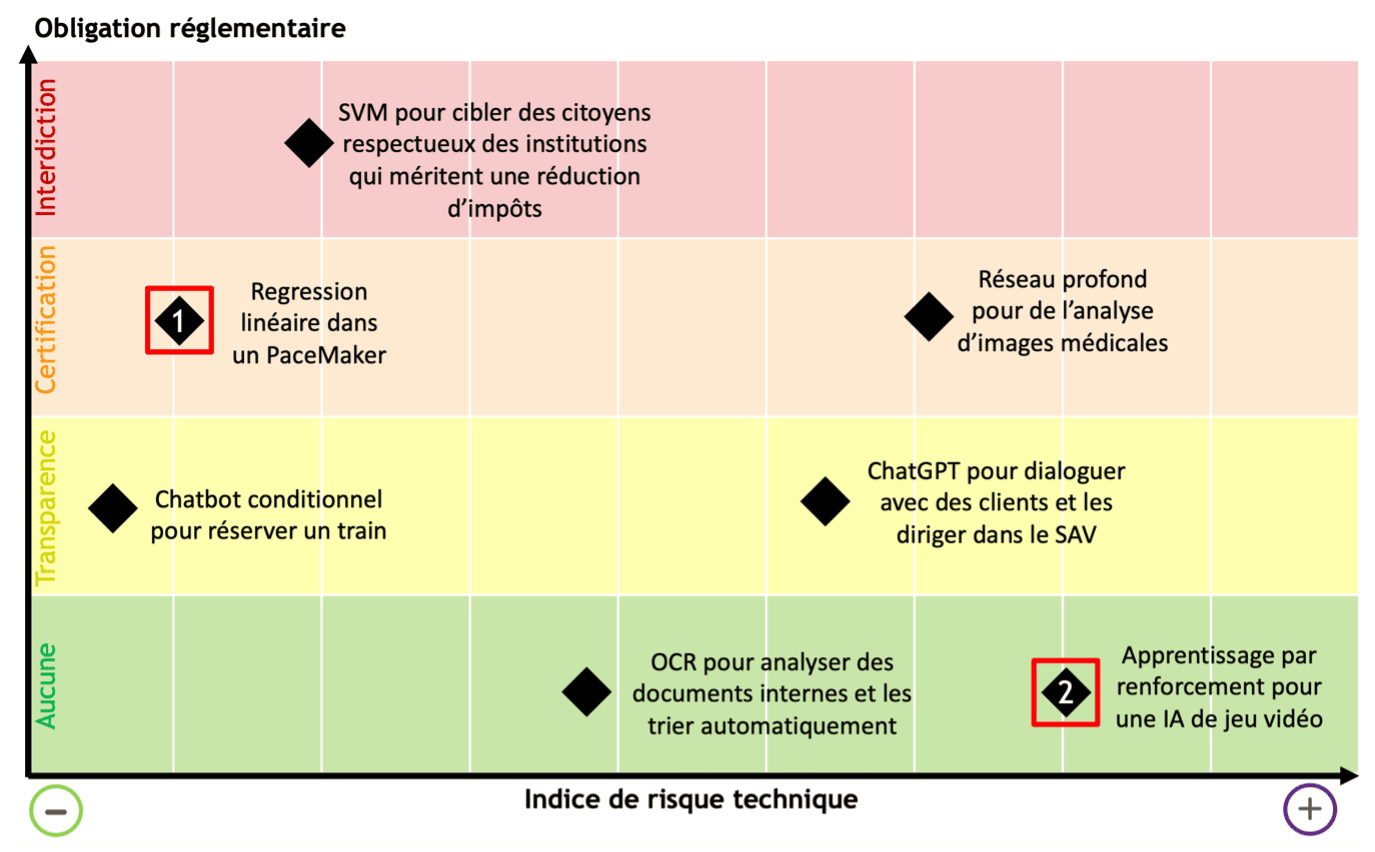

Cette méthodologie prend aussi bien en compte le risque technique entraîné par la complexité (données, modèles, autonomie), que les risques sur les droits fondamentaux représentés par l’obligation réglementaire (voir Figure 2, en santé ou dans le milieu bancaire par exemple).

On peut illustrer cela sur un graphique à deux axes avec des exemples de cas d’usages et leur modèle d’IA utilisé :

Figure 7 : Matrice de catégorisation des risques. Source : Quantmetry.

Cette matrice nous donne deux indicateurs de risques de l’IA pour chaque cas d’usage.

Par exemple, le premier à cas d’usage rouge à gauche, « Régression linéaire dans un PaceMaker », a une obligation réglementaire de certification car son application est susceptible des faire porter des risques sur la santé des personnes. Sa criticité technique reste faible car le modèle utilisé est un modèle intelligible par nature, peu complexe et très bien maîtrisé.

Autre exemple, dans le deuxième cas d’usage en rouge à droite, « Apprentissage par renforcement dans un jeu vidéo », le modèle ici est très compliqué car non-explicable, demande des ressources en infrastructure considérable, et est très complexe à maîtriser et à maintenir. Son niveau de risque technique est donc très élevé. Cependant, son application dans un jeu vidéo a très peu d’impact sur les droits fondamentaux des joueurs, il n’y a donc aucune obligation réglementaire.

Nous avons développé chez Quantmetry une plateforme permettant, en une vingtaine de minutes, de catégoriser les risques de son IA et également de cartographier l’ensemble des IAs d’une organisation. Ce traçage complet permet d’avoir une vue à 360 degrés sur l’ensemble des IAs risquées (et non risquées) d’une entreprise et de l’avancée de leurs audits respectifs dans l’objectif d’une prochaine certification.

Une fois les IA identifiées, comment se déroule un audit interne ?

Une fois les cas d’usages priorisés en fonction du risque réglementaire et des enjeux stratégiques de l’entreprise, nous pouvons attaquer le cœur du processus : l’audit interne du cas d’usage IA.

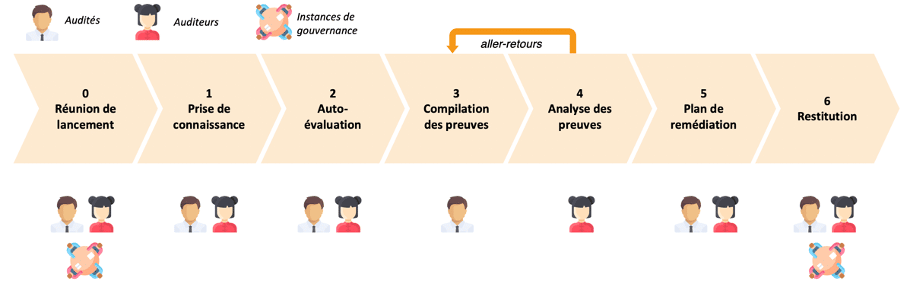

Notre processus d’audit interne se déroule comme suit :

Figure 8 : Processus d’audit interne IA de Confiance pour un cas d’usage donné. Source : Quantmetry.

Dans ce processus, nous distinguons trois acteurs principaux :

- Les audités. Nous conseillons d’avoir un duo composé d’une personne technique (Data Scientist par exemple) et d’une personne avec des compétences métiers (Product Owner).

- Les auditeurs. Ici nous privilégions un duo composé d’un Data Scientist pour l’expertise technique et d’un Data Consultant pour sa prise de recul sur l’intégration du modèle d’IA dans le processus métier cible.

- Les instances de gouvernance. Une équipe responsable de la validation du cas d’usage, de sa conformité (éthique, juridique et sécurité) et du budget associé.

Nous insistons sur la présence d’acteurs représentant le métier. L’audit ne se concentre pas sur le modèle d’IA déployé mais sur le cas d’usage dans sa globalité et l’intégration de celui-ci dans le processus métier !

L’étape « Réunion de lancement » permet de réunir tous les acteurs de l’audit pour les informer de l’objectif de l’audit, de la charge demandée aux équipes ainsi que de l’organisation des différents ateliers. Quant aux autres étapes :

- La première étape « Prise de connaissance » est primordiale pour les auditeurs. Ceux-ci vont poser des questions techniques et métiers sur le cas d’usage afin d’en comprendre les enjeux, l’impact dans le processus métier, les données utilisées et le modèle développé. Les auditeurs pourront ainsi mieux accompagner les équipes lors de la phase suivante.

- Dans la phase « Auto-évaluation », les audités devront remplir un questionnaire dans lequel ils attestent qu’ils répondent spécifiquement aux points soulevés par l’AI Act. Les auditeurs les aiguillent afin de déterminer si ce qu’ils ont réalisé est suffisant. De plus, si l’audité atteste qu’il a effectué une action, celui-ci doit fournir une preuve, c’est-à-dire un document démontrant la réalisation de l’action.

- Dans l’étape « Compilation des preuves », les audités rassemblent l’ensemble des preuves et documents pour chaque action qu’ils estiment avoir menée à bien.

- Après avoir compilé leurs preuves, les audités les partagent aux auditeurs pour rentrer dans l’étape « Analyse des preuves ». Ici, les auditeurs analysent scrupuleusement l’ensemble des preuves pour valider ou invalider les actions réalisées par les équipes projets. Plusieurs aller-retours peuvent être menés avec les audités pour s’assurer que les auditeurs ne manquent pas d’information ou encore pour compléter les preuves.

- Cette auto-évaluation suivie de l’analyse de preuves permet aux auditeurs de coconstruire un « Plan de remédiation » priorisé donnant l’opportunité aux équipes projets d’améliorer leur cas d’usage sur l’ensemble des thématiques de l’IA de Confiance définies en Figure 3.

- La « Restitution» est le rendez-vous final pour restituer aux instances de gouvernance la photographie du cas d’usage et son plan de remédiation. L’audit en tant que tel leur permet de valider ou d’invalider la poursuite du projet si le cas d’usage est très risqué. Si le projet continue, ils pourront décider d’un budget afin de réaliser le plan de remédiation.

Afin d’être très concret sur le contenu de nos audits, nous vous illustrons ici deux de nos livrables (très simplifiés).

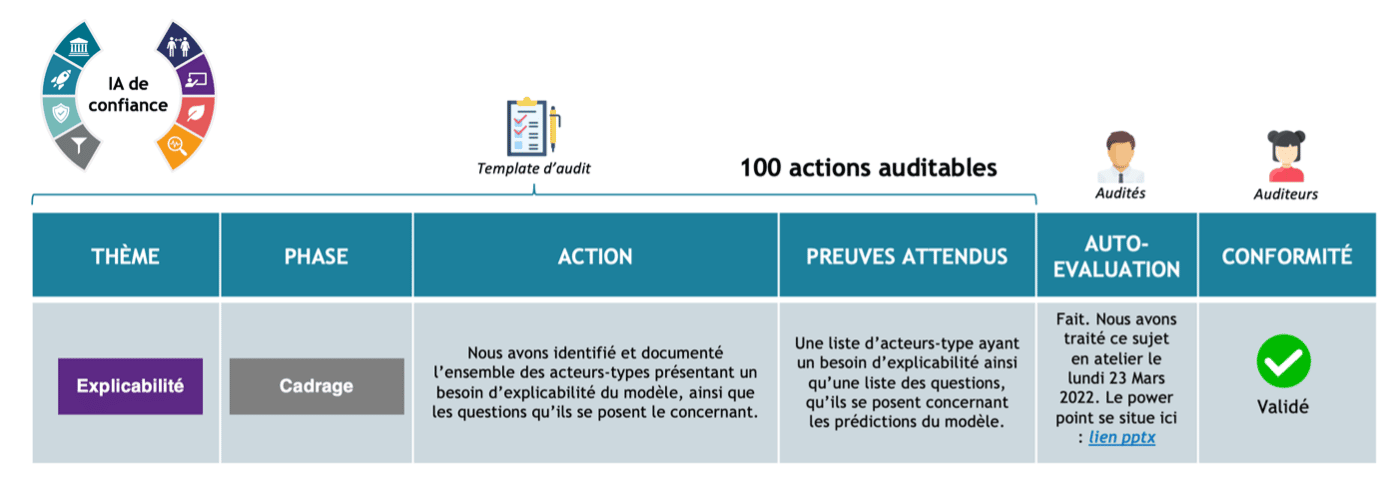

Un exemple d’action auditable parmi 100 autres

Notre questionnaire d’audit comporte 100 actions auditables, nous en présentons une de manière très simplifiée. Elle comporte : le thème d’IA de Confiance associé à l’action, l’action à réaliser, les preuves attendues, l’auto-évaluation de l’audité ainsi que la validation de l’auditeur.

Figure 9 : Exemple d’action auditable issue de la méthodologie d’audit interne IA de Confiance. Source : Quantmetry.

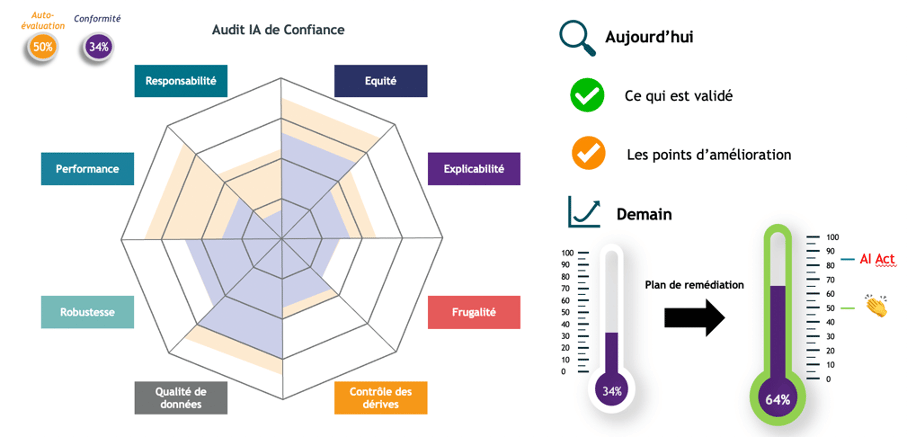

Restitution d’audit : une photographie actuelle et un plan actionnable

Lors de la restitution d’audit, nous présentons un rapport chiffré quant à la conformité du cas d’usage sur l’ensemble des 100 actions auditées. La photographie de l’audit permet d’en tirer les axes à valoriser et ceux à améliorer. Pour finir, on présente le plan de remédiation et sa valeur ajoutée pour atteindre un haut niveau de conformité si le cas d’usage a un objectif de certification.

Figure 10 : exemple de synthèse d’audit interne IA de Confiance. A gauche : les différents scores d’audit ventilés selon les huit dimensions IA de Confiance. En Orange le score d’auto-évaluation et en violet le score de conformité. A droite, une synthèse écrite et une indication du saut de conformité offert par le plan de remédiation coconstruit avec les équipes auditées.

Lors de nos audits, les scores obtenus étaient relativement faibles, aux alentours de 20% à 30%. En effet, seuls les cas d’usage les plus matures atteignent un score avoisinant les 50% ! Les actions auditables demandent un haut niveau de maturité et de précision afin d’être totalement validées. C’est pourquoi les premiers cas d’usage qui se font auditer aujourd’hui seront assurément les premiers prêts pour la réglementation lorsque celle-ci entrera en vigueur dans 3 ans. Rien ne sert de courir, il faut partir à point !

Retours terrains : Des audits bénéfiques pour les équipes techniques, métiers et organisationnelles.

La démarche d’audit interne que nous venons de vous présenter a déjà été appliquée sur une dizaine de cas d’usages et les retours des équipes projets sont extrêmement positifs.

Premier constat : l’IA de confiance comme engagement des collaborateurs

Les équipes techniques sont toutes sensibilisées, à des échelles différentes, aux thématiques de l’IA de Confiance. Ces notions les intéressent et elles ne sont pas du tout réfractaires à prendre du recul sur leur cas d’usage pour vérifier si le leur valide ces thématiques. Acculturation et/ou formation : les équipes souhaitent creuser davantage ces thématiques et les appliquer dans leurs projets. La première chose que ces équipes nous disent en fin d’audit est qu’ils regrettent de ne pas l’avoir fait plus tôt, en début de projet, afin d’anticiper les actions à prendre.

Deuxième constat : les cas d’usage s’améliorent avec l’audit

Les équipes fonctionnelles s’aperçoivent que ces audits internes permettent de mettre en lumière les défauts d’adoption par les équipes métiers (incompréhension des prédictions, modèle peu performant en production, non-équitable, …) et de trouver des solutions de résolution. L’IA de Confiance est la jointure entre la maîtrise technique de l’IA et son utilisation par les équipes métiers.

Troisième constat : un pilotage facilité par la modularité de la méthode

Un tel audit s’inscrit parfaitement dans une démarche projet pour piloter le risque des IAs d’une entreprise. Nos 100 actions auditables sont ventilées par thématique de l’IA de Confiance ainsi que par phase projet. Ainsi il est tout à fait possible de lancer un audit interne dès la phase de cadrage pour anticiper les actions à prendre sur le cas d’usage.

Le plan de remédiation associé à chaque restitution finale permet d’obtenir une feuille de route claire et chiffrée, alignant équipes métiers, techniques et organisationnelles sur le déploiement d’une IA de Confiance. L’application des recommandations et l’amélioration du score de conformité sont des indicateurs à suivre dans le temps. Cela permet notamment de donner un budget clair aux équipes pour faire de la mise en qualité, dans un monde où l’accent est mis sur la rapidité.

L’IA de Confiance apparaît donc nécessairement comme transverse au sein de l’organisation dans laquelle elle agit.

Figure 11 : L’IA de Confiance est totalement transverse au sein de l’organisation et ne peut être traitée en isolation sur un sous-périmètre du cas d’usage. Source : Quantmetry

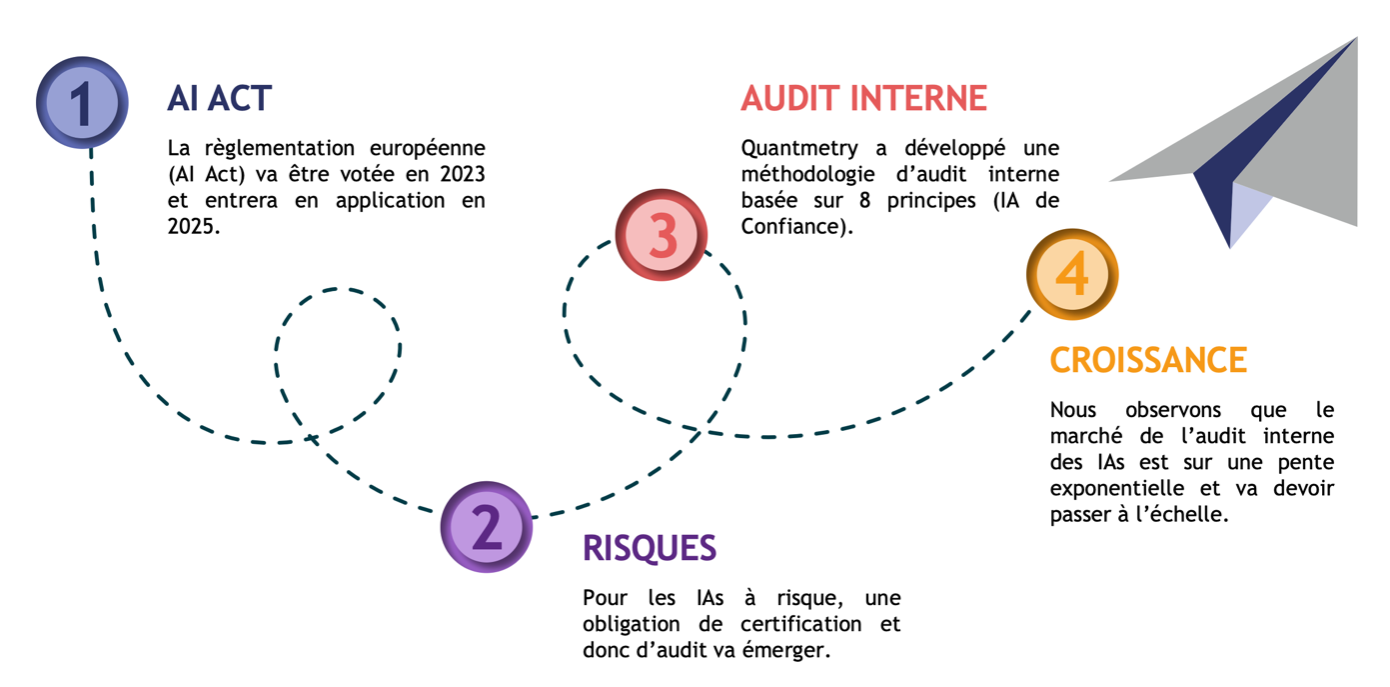

Le marché de l’audit interne des IAs en plein essor

Pour conclure, l’audit interne de cas d’usage IA révèle souvent en pratique des insuffisances organisationnelles chroniques ou redondantes d’un projet à l’autre. La poursuite naturelle de la démarche se situe donc dans l’audit organisationnel des entreprises, afin de s’assurer qu’elles sont bien capables de construire et de gouverner des IAs de confiance par nature. Cette démarche est bien sûr d’autant plus fluide et facilement adoptée qu’elle s’accompagne de parcours d’acculturation et de sensibilisation des instances dirigeantes et des chefs de projet.

Finalement, on peut résumer le combo gagnant de la gouvernance IA de confiance comme suit :

- Une logique d’audit interne IA de confiance des cas d’usage

- La mise en place d’une gouvernance IA de confiance, qui peut être impulsée par un premier audit organisationnel

- Un parcours d’acculturation et de formation à l’IA de confiance dans toutes les strates de l’entreprise

Une telle gouvernance permet d’accompagner les équipes projets dès le premier jour pour qu’elles puissent développer tout en étant conformes à l’IA de confiance par défaut.

Figure 13 : Synthèse des perspectives de l’IA de Confiance. Source : Quantmetry.

En tant que cabinet de conseil, nous observons un vrai boom de la demande sur l’audit interne des IAs, qui va se renforcer avec l’imminence de l’entrée en vigueur de la réglementation européenne.

Et vous, où en êtes-vous sur l’IA de confiance ?

Références

[1] https://papers.nips.cc/paper/2012/hash/c399862d3b9d6b76c8436e924a68c45b-Abstract.html

[3] https://www.reuters.com/article/us-amazon-com-jobs-automation-insight-idUSKCN1MK08G

[4] https://www.bbc.com/news/technology-33347866

[6] https://rss.onlinelibrary.wiley.com/doi/full/10.1111/j.1740-9713.2016.00960.x

[7] https://incidentdatabase.ai/

[8] https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=celex%3A52021PC0206

[11] https://www.parl.ca/DocumentViewer/en/44-1/bill/C-27/first-reading

[12] https://www.nist.gov/itl/ai-risk-management-framework

[14] https://oecd.ai/en/classification

Les membres de l’expertise Reliable AI développent des modèles performants, fiables et maîtrisés, sur l’ensemble du cycle de vie, pour une IA de confiance.

Expert de l'expertise Reliable AI

Grégoire dirige les orientations scientifiques sur le thème IA de confiance, comprenant l’intelligibilité, la robustesse, l’équité et la frugalité des algorithmes.

Data Scientist senior

Philippe est également un artisan de l’expertise Reliable AI. Responsable formation de l'expertise, il a à coeur de partager ses savoirs à tous, tant en interne que chez ses clients.