La frugalité, ou comment empêcher l’IA de franchir les limites

L’intelligence artificielle de Confiance est un sujet que l’on adresse tous les jours chez Quantmetry pour fournir à nos clients des algorithmes de qualité. Ce sujet est traité par l’expertise Reliable AI qui assure la connaissance et l’application de l’état de l’art des 8 thématiques de l’IA de Confiance introduites dans cet article. La frugalité est une de ces 8 composantes.

La frugalité, à quoi ça sert ?

Toutes les activités humaines impactent l’environnement. En effet, elles consistent à y prélever des ressources pour les transformer en quelque chose de plus utile pour une part et en déchet d’autre part. Chacune des étapes (prélèvement, transformation, gestion des déchet) modifie l’environnement en occupant les sols, en utilisant les ressources, ou en modifiant les équilibres physico-chimiques de l’environnement. L’exemple type, au cœur de nos préoccupations environnementales actuelles, est le relargage d’un déchet gazeux, le CO2, qui contribue très significativement au changement climatique. Les effets indésirables liés aux émissions de CO2 vont déjà jusqu’à générer un risque existentiel pour certaines populations, voire pour l’humanité entière sous certaines hypothèses.

Ainsi, les activités humaines visent directement à produire des effets bénéfiques pour l’humanité, mais sont aussi génératrices d’effets indésirables. En prenant pour exemple les grands modèles de langages employés par Chat-GPT, l’entraînement seul de GPT-3 aurait demandé 1300 MWh (soit la puissance d’un réacteur nucléaire du parc Français actuel), pour des émissions équivalentes à 552 tonnes de CO2 (soit l’équivalent de plus de 2,5 millions de kilomètres en voiture thermique) [1]. L’entraînement du modèle GPT-4 actuellement déployé derrière ChatGPT aura probablement eu un impact encore plus important. De plus, si nous ne disposons pas à notre connaissance de la répartition des besoins en énergie entre entraînement et inférence pour les modèles de langages, il est probable qu’elle soit proche de celles observées pour des modèles dont la sollicitation est plus fréquente que l’entraînement de plusieurs ordres de grandeur. C’est typiquement le cas des modèles de Facebook pour lesquelles cette répartition a été récemment publiée : 10% pour des expérimentations, 20% pour les entraînements et 70% pour les inférences [2]. La consommation déjà exubérante de l’entraînement des grands modèles de langages n’est donc probablement que la partie immergée de l’iceberg.

La frugalité vise donc à réduire les impacts environnementaux pour minimiser les effets indésirables et les risques, tout en conservant au maximum les bénéfices des activités humaines. Pour cela, il est indispensable de mesurer et réduire la consommation de ressources pour réduire l’impact sur les conditions environnementales et s’adapter à un environnement limité.

La frugalité, qu’est-ce que c’est ?

Selon le GIEC [3], la frugalité est un ensemble de politiques et de pratiques du quotidien qui évitent en amont la demande en ressources naturelles (énergie, eau, matériaux, sols…) tout en garantissant le bien-être de tous dans le respect des limites planétaires. Traduit dans le contexte de l’intelligence artificielle, la frugalité s’applique sur 3 axes.

Frugalité des infrastructures

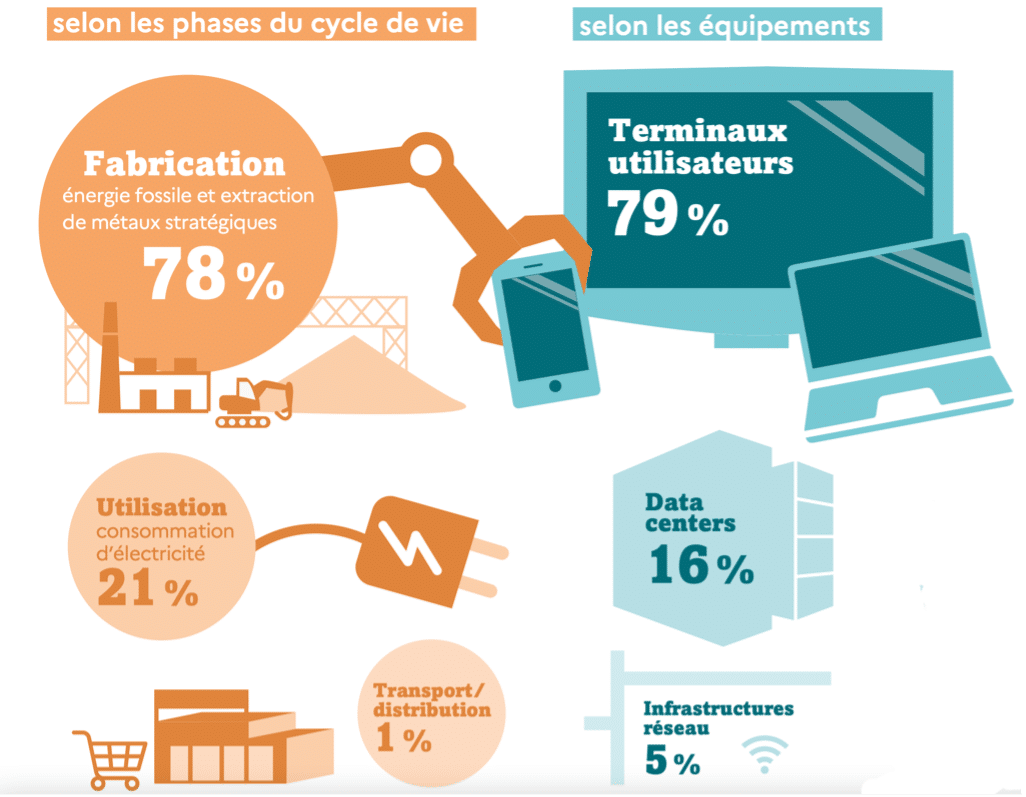

Figure 1 : Répartition de l’empreinte carbone pour le secteur IT [4] : 78% de l’empreinte est générée dès la fabrication des équipements, leur utilisation n’en représente que 21%. De même les terminaux utilisateurs (équipements à écran) concentrent 79% de l’empreinte carbone. La décarbonation du secteur IT ne peut donc se passer d’une réflexion sur l’usage des équipements, en particulier des terminaux.

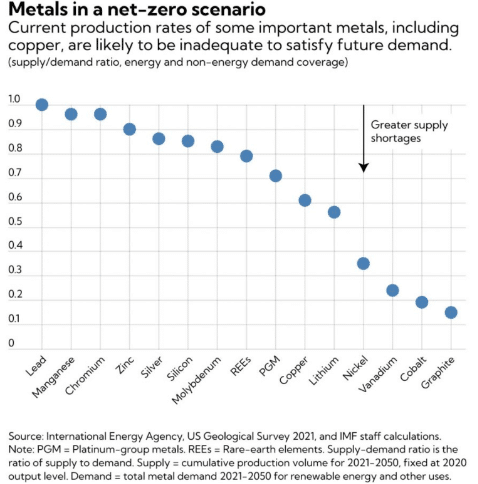

En France, la fabrication des terminaux représente entre 75% et 80% des émissions de CO2 du cycle de vie des équipements informatiques [4]. De plus, la fabrication des équipements requiert une diversité de métaux dont les concentrations des gisements deviennent de plus en plus faibles augmentant donc l’emprise territoriale des mines pour une même quantité de métaux. A ces impacts s’ajoute également la demande croissante en métaux provenant de la transition énergétique des sociétés [5]. Cette croissance pourrait dépasser les capacités de production menant à une forte compétition pour ces ressources [6]. Des alertes ont d’ores et déjà été émises concernant certains métaux : cobalt, nickel, lithium, cuivre [7]. Il est donc à tout point de vue nécessaire et avantageux de chercher dès à présent à limiter la quantité d’appareils connectés, ordinateurs, serveurs, et écrans utilisés par le secteur IT en général et par le secteur de l’IA en particulier.

Figure 2 : Pour certains métaux les prévisions de la demande dépassent largement les capacités de production actuelles. Les investissements actuels déterminent l’intensité de la compétition pour ces ressources. Les scénarios impliquant des arbitrages sur l’usage de ces ressources doivent être considérés .

Frugalité des données

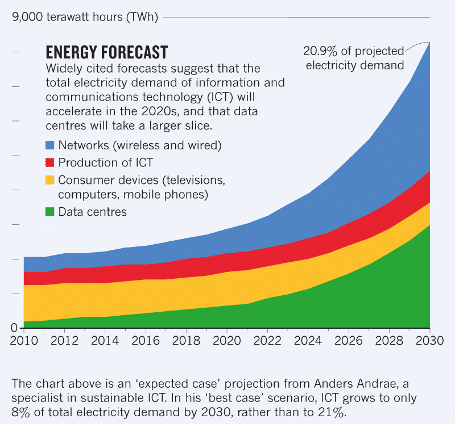

Figure 3 : Prévision de l’évolution de la demande en énergie du secteur IT [6] : la demande en énergie du secteur IT devrait connaître une croissance exponentielle dans la décennie à venir. Cette croissance repose en grande partie sur l’augmentation des besoins au niveau des data centers.

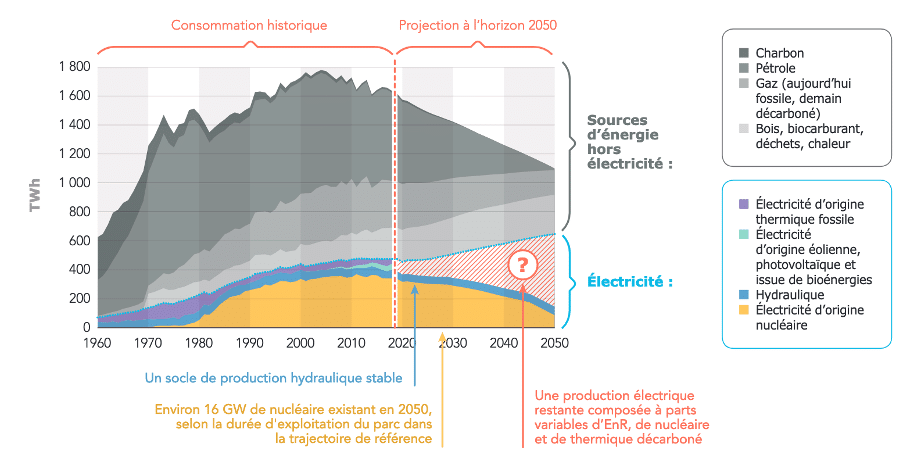

La demande en énergie du secteur IT pourrait connaitre une croissance exponentielle en passant de 4% à 21% de la demande globale en 2030 (voir figure 3) [8]. Cette croissance est en grande partie soutenue par l’augmentation des besoins des data centers. En effet leur demande pourrait passer de 1% à 8% de la demande mondiale en 2030 [8]. Cette augmentation proviendrait de la multiplication des usages du numérique, qui décuplerait la quantité de données stockées sur le cloud. Là encore, cette demande croissante pour le stockage des données entrera en compétition avec l’électrification des activités humaines pour l’accès à l’énergie. En France, la capacité de production électrique pour les prochaines décennies est incertaine (voir figure 4), du fait du vieillissement du parc nucléaire, et dépendra des investissements réalisés actuellement dans le renouvelable et le nucléaire [9]. Réduire la quantité de données stockées pour l’adapter au plus juste pour les usages essentiels est donc également important et avantageux pour limiter les risques.

Figure 4 : Prévision de la répartition de l’énergie utilisée en France [9] : Il existe un gap entre les capacités de production actuelles et la demande anticipée pour les années à venir. Cette différence a trois sources : la hausse de la demande, la substitution des sources d’énergies carbonées par de l’électricité et le vieillissement des infrastructures nucléaires actuelles. Elle devra être comblée par le déploiement de nouveau nucléaire ou de capteurs d’énergies renouvelables. Là encore, des scénarios de compétition entre les usages du secteur IT et de la transition ne sont pas à exclure. L’intensité de la compétition dépendra de la rapidité du déploiement des nouveaux modes de production.

Frugalité des modèles

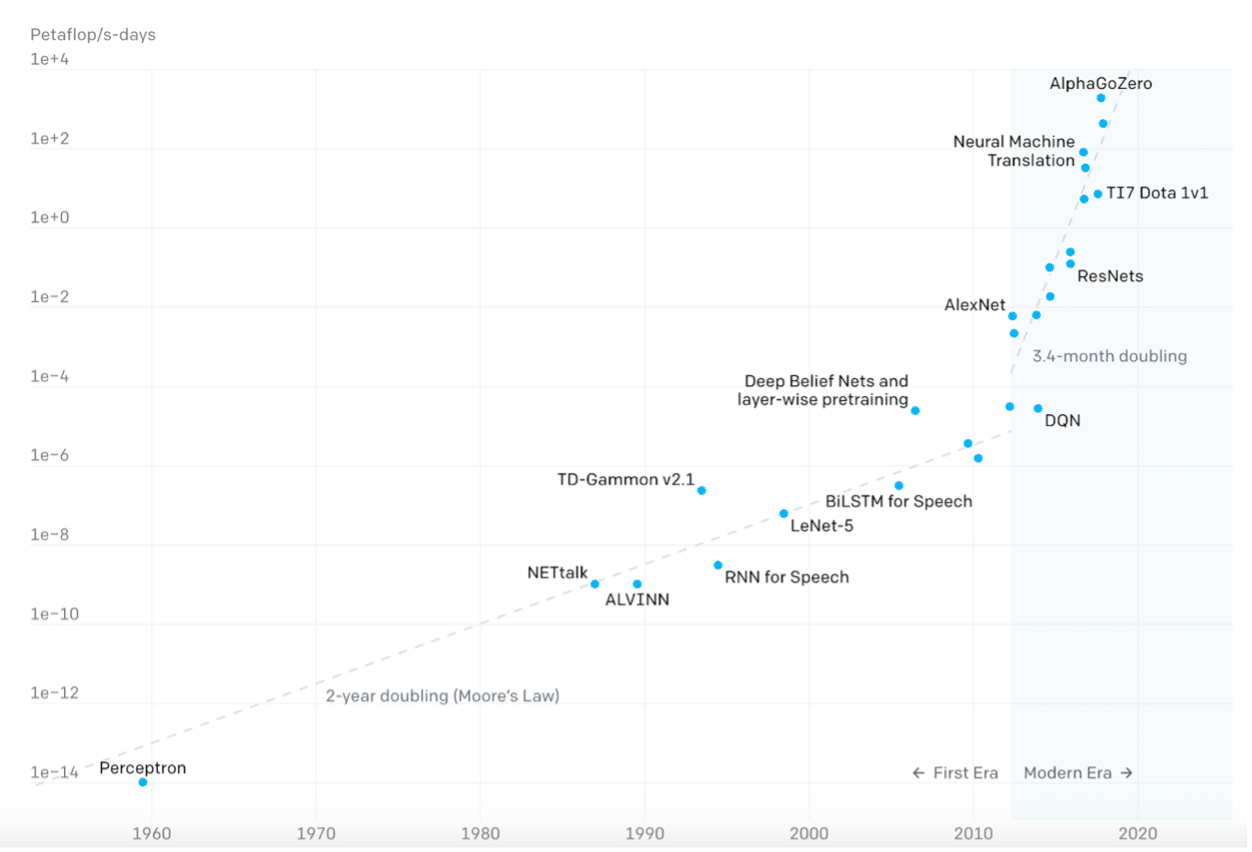

Figure 5 : Évolution de la demande en calcul des modèles à l’état de l’art entre 1960 et 2020 [10] : Le nombre d’opérations (petaflop par seconde – jour) nécessaires à l’entraînement des modèles à l’état de l’art n’a cessé de croître de manière exponentielle. Depuis les années 2010 cette croissance s’est même accélérée.

Enfin, la demande en calcul des modèles les plus impressionnants ne cesse de croitre. Cette croissance est de plus devenue exponentielle depuis les années 2010 [10]. Elle est actuellement huit fois plus rapide que la loi de Moore, qui décrit les gains énergétiques des processeurs, donc leur capacité à faire plus de calcul pour une même quantité d’énergie [10]. L’évolution de ces gains atteint de plus des limites physiques qui suggèrent que l’augmentation exponentielle des capacités de calcul va cesser. Ainsi de même que pour le stockage des données, les besoins en calcul des IA risquent d’entrer en compétition avec les autres activités humaines pour l’accès à l’énergie. Minimiser la complexité des algorithmes pour faire des modèles moins généralistes, mais plus spécialisés dans les usages essentiels est donc aussi nécessaire et avantageux.

La frugalité, comment l’activer ?

Mesurer

Avant toute action, il faut avoir une vision de bout-en-bout de la consommation énergétique. En effet, sans cela, il n’est pas possible d’identifier les points les plus consommateurs pour réduire leur impact sur la chaîne de traitement. Par exemple, sans considérer l’impact des équipements, réduire la consommation énergétique d’un modèle en production pour le déployer sur plusieurs dizaines de milliers de tablettes dédiées uniquement à cet usage pourrait paraître frugal. Cependant l’impact de la fabrication seule des tablettes dépassera largement les gains obtenus sur le modèle en production.

Il est donc nécessaire de mesurer la consommation énergétique liée au cycle de vie de la donnée (entraînement, inférence), des modèles (optimisation, déploiement, réentrainements), et des équipements. Ces mesures sont ensuite rassemblées dans une analyse documentée de la consommation énergétique des cas d’usage.

Convertir

La consommation d’énergie seule ne permet pas d’évaluer un impact environnemental et donc de déterminer si elle est acceptable ou non. Il faut donc convertir la consommation énergétique en empreinte carbone, voire en empreinte environnementale (prenant en compte l’extraction des métaux par exemple).

Pour cela, il est possible de s’appuyer sur les spécifications hardware des infrastructures sollicitées et sur le mix énergétique des pays ou data centers dans lesquels s’effectuent les calculs pour obtenir l’empreinte carbone des cas d’usage. Les calculs sont ensuite référencés dans une analyse documentée de conversion en empreinte carbone ou environnementale.

Réduire

Enfin il convient de supprimer ou optimiser les facteurs dominants lors du calcul de l’empreinte précédemment réalisée pour réduire l’impact des projets.

Des actions doivent être prises à cet effet sur la chaîne de traitement, qui s’ajoutent aux recommandations générales déjà présentées dans notre précédent article [11] :

- Concernant les données : réduire autant que possible leur volumétrie, compresser les données lues occasionnellement, voire stocker sur bande magnétique les données archivées pour contraintes réglementaire mais qui ne seront plus lues. C’est à dire mettre en place un processus de gestion du cycle de vie des données.

- Employer des méthodes efficaces d’optimisation des hyperparamètres des modèles : mettre en place des études de scaling des modèles, utiliser des méthodes d’exploration optimisée (optimisation bayésienne, algorithmes génétiques), voire informer les modèles à partir des connaissances métiers. C’est-à-dire mettre en place une gouvernance de la connaissance au sein de l’organisation.

- Pour la gestion du cycle de vie des modèles : définir la plage de performances acceptables du modèle et en déduire la fréquence de réentrainement optimale ainsi que la granularité minimum de versioning nécessaire. Cette plage de performances permet également la sélection de modèles moins complexes, ou la compression de modèles de réseau de neurones pour diminuer leur consommation électrique en production. De plus l’analyse des usages permet d’arbitrer entre le déploiement d’un modèle généraliste (donc complexe) ou de plusieurs modèles spécialisés (donc simples). Il s’agit donc de mettre en place une gouvernance des usages des données.

Les actions mises en place font ensuite l’objet d’une analyse documentée de la réduction de l’empreinte obtenue.

La frugalité, en vrai ça donne quoi ?

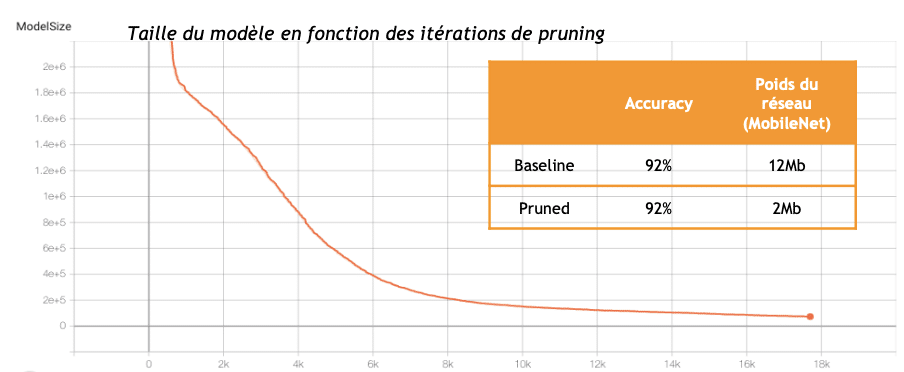

Figure 6 : Résultat de la simplification d’un réseau de neurones : des poids sont annulés itérativement (ce qui équivaut à supprimer des connexions entre les neurones du modèle) et la performance du modèle est évaluée après chaque suppression de connexion. Le modèle final est aussi performant que le modèle initial mais beaucoup plus léger.

Nous avons appliqué ces principes pour un client qui souhaitait détecter des défauts sur les canalisations de gaz (dégradation, peinture qui s’écaille…). Nous avons alors cherché à doter les techniciens d’une application de reconnaissance automatique de ces défauts. Ces diagnostics peuvent avoir lieu dans des zones blanches (sans réseau mobile), dans des caves ou des égouts. L’application doit donc être embarquée et consommer peu de batterie. Pour parvenir à ce résultat, nous avons compressé le réseau de neurones de traitement d’image pour qu’il soit beaucoup plus léger et rapide.

Nous avons pour cela mis en place une stratégie d’élagage du modèle (voir figure 6). A chaque itération du processus de simplification, nous avons mesuré la taille et les performances du modèle. Nous avons ainsi pu diviser par 10 la taille du modèle tout en conservant des performances très élevées. Ce qui est effectivement un pas vers la frugalité tant qu’on parvient à éviter le paradoxe de Jevons [12] ou un effet rebond plus modeste.

En conclusion, le réchauffement climatique et la raréfaction des ressources créent un contexte d’incertitude et de risques dans lequel la frugalité des systèmes informatiques, et de l’IA en particulier, devient un enjeu de résilience incontournable. L’objectif de la frugalité est de chercher à réduire le plus en amont possible les besoins en énergie et en matériaux d’un projet. Si elle est aujourd’hui largement abordée du point de vue énergétique, cet aspect ne représente en France que 25% au mieux de l’impact des IA, et le traiter seul risque fortement de conduire à un effet rebond qui en annulerait tous les bénéfices. Il est probable que les usages multiples de l’électricité et des métaux liés à la transition énergétique contraignent le secteur de l’IA à considérer également les aspects matériels des projets. Ces considérations ne pourront certainement pas se passer d’une réflexion sur les usages qui devront alors s’inscrire dans un environnement limité tout en s’alignant avec les projets d’entreprise et en étant source de forte valeur ajoutée.

Sources

[1] Carbon Emissions and Large Neural Network Training, Patterson et al., 2021

[2] Substainable AI: Environmental Implications, Challenges and Opportunities, Wu et al., 2022

[3] Résumé aux décideurs du Volet 3 du sixième rapport du GIEC, 2022, p 31, note 59

[4] Infographie ADEME : impacts environnementaux du numerique

[9] Futur Énergétiques- Principaux Résultats, RTE, p14, Octobre 2021

[10] AI and Compute, Open AI, 16 Mai 2018

[12] Paradoxe de Jevons, wikipedia

Les membres de l’expertise Reliable AI développent des modèles performants, fiables et maîtrisés, sur l’ensemble du cycle de vie, pour une IA de confiance.

Data Scientist Senior chez Reliable AI

Geoffray est un des artisans de l’expertise Reliable AI. Il utilise des modèles explicables par nature pour résoudre en production les problématiques de nos clients : prévision de la demande, estimation de risques en maintenance prédictive et dimensionnement d’études.