Intelligence Artificielle de confiance – comprendre les enjeux de la prochaine décennie

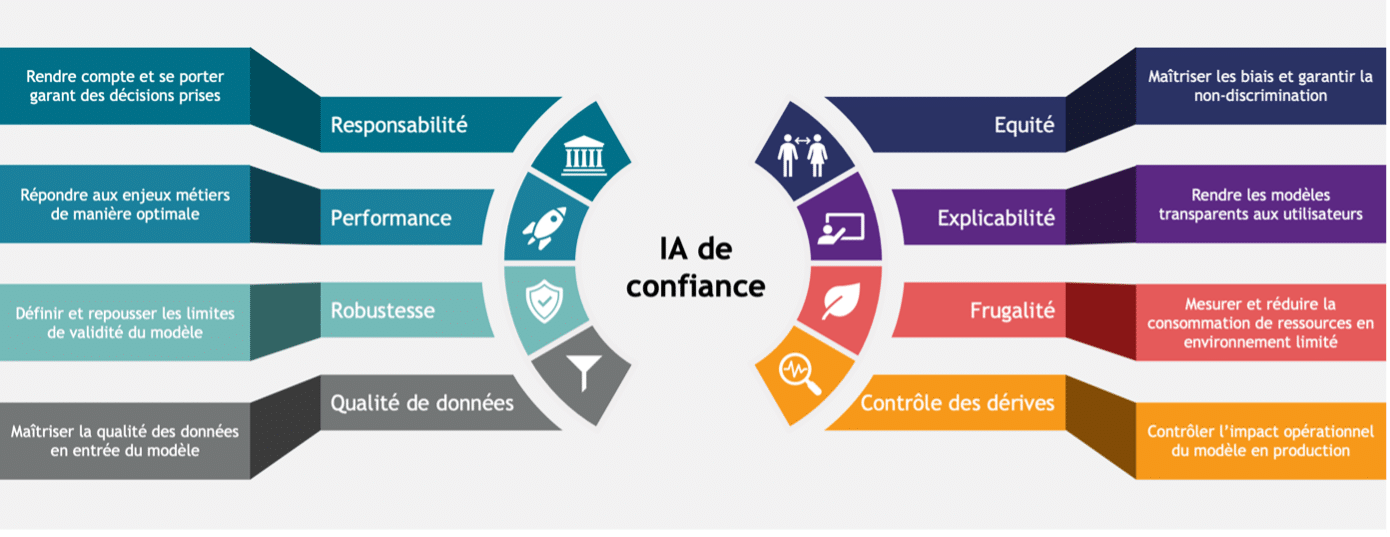

Au sein de Quantmetry, riches de nos dix années d’expérience en réalisation de projets d’Intelligence Artificielle (IA) de bout-en-bout, et à la pointe des enjeux stratégiques, scientifiques et réglementaires à venir, nous avons formalisé l’IA de confiance en huit thèmes fondamentaux.

Notre expertise Intelligence Artificielle de confiance de dix personnes, travaille sur le sujet depuis bientôt sept ans, et nous accompagnons toutes les entreprises, petites grandes ou moyennes, à définir et à implémenter une stratégie IA de confiance. En étant irréprochable sur ces 8 thèmes, les entreprises que nous accompagnons sont certaines de gagner en excellence opérationnelle et de maîtriser leurs risques financiers, réglementaires ou réputationnels.

Les piliers de l’IA de Confiance. Source : Quantmetry

A travers cette série d’articles, nous vous proposons de plonger en détail dans chacun de ces huit thèmes, afin de :

- Comprendre leur signification

- Saisir leurs implications sur les projets IA

- Les illustrer via des cas d’usage réels

Retrouvez nos articles détaillés sur l’IA de confiance :

- Responsabilité

- Performance

- Robustesse

- Qualité de données

- Equité

- Explicabilité

- Frugalité

- Contrôle des dérives

Ces huit thématiques sont motivées par un double constat : l’IA est en croissance exponentielle, et sa régulation est en train de se mettre en place partout dans le monde.

Le marché de l’IA : une croissance folle encore incontrôlée

Depuis 2012 et l’effet de souffle créé par la compétition ImageNet [1], le marché de l’intelligence artificielle (IA) est en croissance exponentielle [2]. Tout le tissu économique s’en imprègne, tant et si bien que nous ne passons plus une journée sans interagir avec une IA.

En parallèle de cette évolution, on observe également une recrudescence des risques associés à un usage incontrôlé de l’IA. Certaines d’entre elles ont discriminé des femmes sur le marché de l’emploi [3], ont confondu des afro-américains avec des gorilles [4], ont recommandé à des patients dépressifs de se suicider [5], ou ont incité les policiers à accroître les inégalités de surveillance policière [6]. Aujourd’hui, il existe même une base de données publique recensant nombre de scandales liés à l’utilisation incontrôlée de l’IA dans le monde [7].

Dans le monde de l’entreprise, la dérive des coûts liée à la non-qualité des projets, le besoin de transparence des utilisateurs, ou encore le maintien en conditions opérationnelles, sont autant de raison d’adresser le sujet de l’IA de confiance, qui rime souvent avec excellence.

Enfin, la récente démocratisation des « general purpose AIs », en particulier les IAs génératives comme Midjourney [8], Stable Diffusion [9] ou ChatGPT [10] accroissent la demande sociétale autour d’une régulation de cette technologie. Certaines figures de proue du domaine comme Yoshua Bengio ou Elon Musk réclament même une pause dans le développement de telles IAs afin de laisser émerger un cadre normatif de contrôle des risques [11].

L’AI Act : un cadre normatif imminent pour les IAs à risque

En réponse à cette recrudescence des risques, l’Union Européenne a proposé un règlement visant à réguler les IAs au sens large. Les IAs jugées à risques sont au cœur des préoccupations [12]. Le règlement s’appliquera à tout acteur, même extérieur à l’Union Européenne, dès lors qu’il déploie une IA sur le territoire européen. Le texte de loi sera voté de manière imminente, au cours de l’année 2023, et sera pleinement applicable à horizon 2026, sur le même modèle que le déploiement du Règlement Général pour la Protection des Données (RGPD) [13].

L’émergence de cadres réglementaires tels que l’AI Act répond en réalité à une crise de confiance, et trouve de nombreux échos dans le monde entier, comme nous l’avons déjà écrit dans notre précédent article de blog [14] (le rapport Villani en France [15], l’Artificial Intelligence and Data Act au Canada [16], les standards du NIST [17] ou encore l’Algorithmic Accountability Act aux Etats-Unis [18]). A l’instar des secteurs déjà réglementés comme la banque ou l’aéronautique, c’est bien une logique de gestion de la qualité que l’on voit se mettre en place chez les acteurs les plus en avance sur le sujet. L’audit interne IA de confiance, tel que nous l’avons détaillé dans notre article dédié [19], semble être une des approches les plus efficaces pour les entreprises d’absorber ce futur choc réglementaire.

Voulez-vous prendre le virage de l’IA de confiance ?

Vous voulez prendre le virage de l’IA de confiance mais vous ne savez pas par où commencer ? Quantmetry vous offre une session gratuite de découverte de l’IA de confiance à travers un jeu de cartes. Vous choisissez un cas d’usage, et à la fin de la partie vous avez identifié les points forts et les axes prioritaires à développer pour rendre votre IA de confiance. Facile, et ludique !

Pour en savoir plus, contactez Raphaël Viné : rvine@quantmetry.com.

Références

[2] L’intelligence artificielle, un marché qui vaut des milliards

[3] Amazon scraps secret AI recruiting tool that showed bias against women

[4] Google apologises for Photos app’s racist blunder

[5] Medical chatbot using OpenAI’s GPT-3 told a fake patient to kill themselves

[10] ChatGPT

[11] Pause Giant AI Experiments: An Open Letter

[12] Artificial Intelligence Act

[13] General Data Protection Regulation

[14] Panorama du contexte réglementaire et des initiatives IA de confiance

[15] Rapport de Cédric Villani : donner un sens à l’intelligence artificielle

[16] Bill C-27

[17] NIST AI Risk Management Framework

[18] H.R. 6580

[19] Audit interne des IAs : la confiance au coeur de la démarche

Les membres de l’expertise Reliable AI développent des modèles performants, fiables et maîtrisés, sur l’ensemble du cycle de vie, pour une IA de confiance.

Senior Expert IA de Confiance chez Quantmetry

Grégoire anime l’expertise IA de confiance de Quantmetry. Il structure la veille et dirige les orientations scientifiques sur le thème IA de confiance. Il est le référent R&D de tous les projets visant à établir une méthodologie d’homologation des IAs.